App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

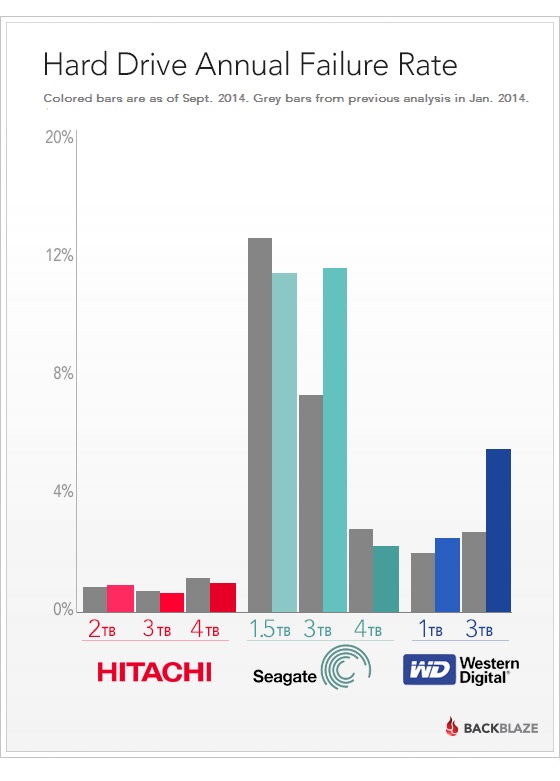

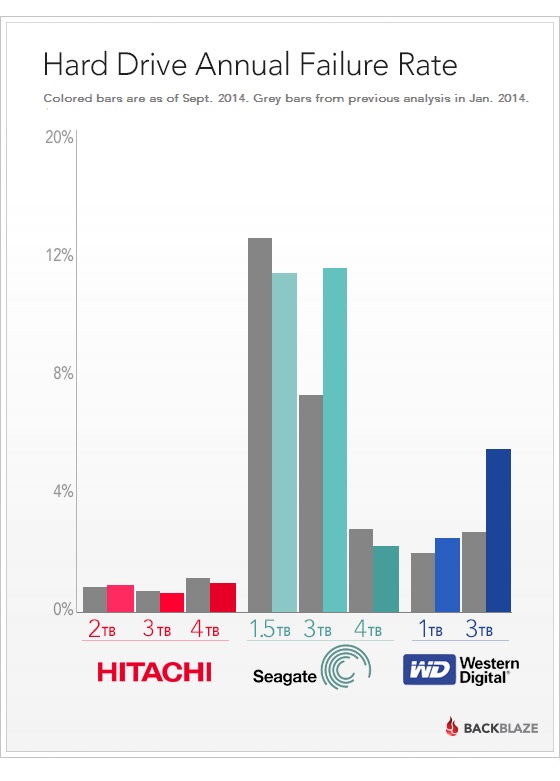

News Hohe Ausfallraten für Seagate und WD HDDs in Blackblaze Datacenter

- Ersteller Complicated

- Erstellt am

User-News

Von Complicated

Hinweis: Diese "User-News" wurde nicht von der Planet 3DNow! Redaktion veröffentlicht, sondern vom oben genannten Leser, der persönlich für den hier veröffentlichten Inhalt haftet.In einer detaillierten Tabelle hat Blackblaze Datacenter die Ausfallraten der verwendeten HDD-Festplatten dokumentiert. Das besondere bei dem Anbieter von unbegrenztem Online-Backup-Volumen ist die Verwendung von normalen Consumer-HDDs, welche sie auch auf normalen Vertriebswegen erwerben. Zum Berichtszeitpunkt waren 34.881 Festplatten mit über 100 Petabytes an Daten im Einsatz.

Besonders auffällig sind die 3 TB Modelle von Seagate und WD Red. Eine detaillierte Liste findet sich in dem Bericht.

Quellen:

https://www.backblaze.com/blog/hard-drive-reliability-update-september-2014/

Besonders auffällig sind die 3 TB Modelle von Seagate und WD Red. Eine detaillierte Liste findet sich in dem Bericht.

Quellen:

https://www.backblaze.com/blog/hard-drive-reliability-update-september-2014/

Zuletzt bearbeitet:

SPINA

Grand Admiral Special

- Mitglied seit

- 07.12.2003

- Beiträge

- 18.122

- Renomée

- 985

- Mein Laptop

- Lenovo IdeaPad Gaming 3 (15ARH05-82EY003NGE)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- ASUS PRIME X370-PRO

- Kühlung

- AMD Wraith Prism

- Speicher

- 2x Micron 32GB PC4-25600E (MTA18ASF4G72AZ-3G2R)

- Grafikprozessor

- Sapphire Pulse Radeon RX 7600 8GB

- Display

- LG Electronics 27UD58P-B

- SSD

- Samsung 980 PRO (MZ-V8P1T0CW)

- HDD

- 2x Samsung 870 QVO (MZ-77Q2T0BW)

- Optisches Laufwerk

- HL Data Storage BH16NS55

- Gehäuse

- Lian Li PC-7NB

- Netzteil

- Seasonic PRIME Gold 650W

- Betriebssystem

- Debian 12.x (x86-64)

- Verschiedenes

- ASUS TPM-M R2.0

Über die Aussagekraft lässt sich bestimmt streiten, aber es deckt sich mit meiner eigenen (mehrjährigen) Erfahrung mit den Herstellern.

BoMbY

Grand Admiral Special

- Mitglied seit

- 22.11.2001

- Beiträge

- 7.468

- Renomée

- 293

- Standort

- Aachen

- Details zu meinem Desktop

- Prozessor

- Ryzen 3700X

- Mainboard

- Gigabyte X570 Aorus Elite

- Kühlung

- Noctua NH-U12A

- Speicher

- 2x16 GB, G.Skill F4-3200C14D-32GVK @ 3600 16-16-16-32-48-1T

- Grafikprozessor

- RX 5700 XTX

- Display

- Samsung CHG70, 32", 2560x1440@144Hz, FreeSync2

- SSD

- AORUS NVMe Gen4 SSD 2TB, Samsung 960 EVO 1TB, Samsung 840 EVO 1TB, Samsung 850 EVO 512GB

- Optisches Laufwerk

- Sony BD-5300S-0B (eSATA)

- Gehäuse

- Phanteks Evolv ATX

- Netzteil

- Enermax Platimax D.F. 750W

- Betriebssystem

- Windows 10

- Webbrowser

- Firefox

Die Hitachi-Platten machen auf jeden Fall weiterhin einen sehr guten Eindruck.

OBrian

Moderation MBDB, ,

- Mitglied seit

- 16.10.2000

- Beiträge

- 17.032

- Renomée

- 267

- Standort

- NRW

- Details zu meinem Desktop

- Prozessor

- Phenom II X4 940 BE, C2-Stepping (undervolted)

- Mainboard

- Gigabyte GA-MA69G-S3H (BIOS F7)

- Kühlung

- Noctua NH-U12F

- Speicher

- 4 GB DDR2-800 ADATA/OCZ

- Grafikprozessor

- Radeon HD 5850

- Display

- NEC MultiSync 24WMGX³

- SSD

- Samsung 840 Evo 256 GB

- HDD

- WD Caviar Green 2 TB (WD20EARX)

- Optisches Laufwerk

- Samsung SH-S183L

- Soundkarte

- Creative X-Fi EM mit YouP-PAX-Treibern, Headset: Sennheiser PC350

- Gehäuse

- Coolermaster Stacker, 120mm-Lüfter ersetzt durch Scythe S-Flex, zusätzliche Staubfilter

- Netzteil

- BeQuiet 500W PCGH-Edition

- Betriebssystem

- Windows 7 x64

- Webbrowser

- Firefox

- Verschiedenes

- Tastatur: Zowie Celeritas Caseking-Mod (weiße Tasten)

Sehr löblich von denen, so eine Statistik zu veröffentlichen, ohne daß sie dafür was bekommen. Immerhin wird so ein Konkurrent auf dem Datacenter-Markt nicht diese schlechten Erfahrungen machen müssen und gleich die guten Platten kaufen. Wirklich sehr altruistisch von denen, solche Geschäftsgeheimnisse zu veröffentlichen, damit alle was davon haben. Oder andersrum gesagt: So ganz traue ich solchen Veröffentlichungen nicht, da kann auch Geld von einem Plattenhersteller geflossen sein, um besser dazustehen bzw. den anderen schlechter dastehen zu lassen.

das gleiche thema wie seiner zeit bei google ... consumer-hardware in server-umgebungen.

https://www.youtube.com/watch?v=zqfkN7x-AfA&list=UUpIVQUYBArvA9JcnGJksxGA

https://www.backblaze.com/blog/backblaze-storage-pod-4/

das lustige ist, dass sie in blog-einträgen deutlich machen, dass sie zur zeit der thailand-flut wirklich alles, aber auch wirklich alles aus den hinterletzten winkeln x-beliebiger shops zusammenkauft haben. da sind dann halt auch usb-festplatten dabei, die sie auseinanderschrauben. einerseits ist die story ganz amüsant, aber wenn solche beschaffungs-szenarien die regel sein sollen ...

gute frage ... immerhin gehen sie recht offen z.b. mit den details zu ihren storage pods um.So ganz traue ich solchen Veröffentlichungen nicht, da kann auch Geld von einem Plattenhersteller geflossen sein, um besser dazustehen bzw. den anderen schlechter dastehen zu lassen.

https://www.youtube.com/watch?v=zqfkN7x-AfA&list=UUpIVQUYBArvA9JcnGJksxGA

https://www.backblaze.com/blog/backblaze-storage-pod-4/

das lustige ist, dass sie in blog-einträgen deutlich machen, dass sie zur zeit der thailand-flut wirklich alles, aber auch wirklich alles aus den hinterletzten winkeln x-beliebiger shops zusammenkauft haben. da sind dann halt auch usb-festplatten dabei, die sie auseinanderschrauben. einerseits ist die story ganz amüsant, aber wenn solche beschaffungs-szenarien die regel sein sollen ...

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Ja da habe ich auch amüsiert gelesen

bbott

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 4.363

- Renomée

- 60

- Mein Laptop

- HP Compaq 8510p

- Details zu meinem Desktop

- Prozessor

- AMD FX-8370

- Mainboard

- Asus M5A99X

- Kühlung

- Corsair H60

- Speicher

- 16GB DDR3-1866 Crucial

- Grafikprozessor

- Sapphire HD5770

- Display

- 4k 27" DELL

- SSD

- Samsung Evo 850

- HDD

- 2x Seagate 7200.12

- Optisches Laufwerk

- Pioneer, Plextor

- Soundkarte

- Creative X-Fi Xtreme Music

- Gehäuse

- Silverstone TJ-02S

- Netzteil

- Enermax 450W

- Betriebssystem

- Windows 7

Da Desktop Platten als Server Platten Betreiben wurden ist die Aussagekraft recht beschränkt, außer man strebt einen 24/7 Betrieb ohne Idle an.

Die Bisher veröffentlichten Zahlen Sprechen meist eher gegen Hitachi:

z. B. http://www.behardware.com/articles/881-6/components-returns-rates-7.html

Zumal auch die Ausfallrate mit steigender Anzahl an Plattern steigt und Hitachi immer min. ein Plattern mehr benötigt hat man Nachteile bei:

- Performance (Datenübertragunsrate und Latzenz)

- Leitungsaufnahme

- Lautstärke

- Haltbarkeit

Wenn die anderen Hersteller es nicht verbocken sollte man Hitachi in diesen Punkten schlagen können.

Mir Persönlich ist noch keine Platte von Samsung, Seagate und Hitachi abgetaucht und eine WD mit Defekten Sektoren wurde getauscht. Von Samsung und Seagate habe ich je welche mit einen defekten Sektor und beide laufen noch. Ich kaufe jeweils Platten mit der "maximalen Anzahl Plattern -1", um den erhöhten Ausfallraten der großen HDDs aus dem weg zu gehen. Bisher bin ich damit ganz gut gefahren.

Ich bin Hitachi gegenüber sehr skeptisch, was auch an deren Produkt Strategie z. B. Helum zu verwenden betrifft, gleiches gilt auch für das "Shingle Magnetic Recording" da betrifft es aber primär die Performance und weniger die Sicherheit/Haltbarkeit.

Ich hatte gehofft das endlich die Mechanik aus dem HDD-Gehäuse verbannt wird und per Laser die Daten Übertragung massiv erhöht wird.

Die Bisher veröffentlichten Zahlen Sprechen meist eher gegen Hitachi:

z. B. http://www.behardware.com/articles/881-6/components-returns-rates-7.html

Zumal auch die Ausfallrate mit steigender Anzahl an Plattern steigt und Hitachi immer min. ein Plattern mehr benötigt hat man Nachteile bei:

- Performance (Datenübertragunsrate und Latzenz)

- Leitungsaufnahme

- Lautstärke

- Haltbarkeit

Wenn die anderen Hersteller es nicht verbocken sollte man Hitachi in diesen Punkten schlagen können.

Mir Persönlich ist noch keine Platte von Samsung, Seagate und Hitachi abgetaucht und eine WD mit Defekten Sektoren wurde getauscht. Von Samsung und Seagate habe ich je welche mit einen defekten Sektor und beide laufen noch. Ich kaufe jeweils Platten mit der "maximalen Anzahl Plattern -1", um den erhöhten Ausfallraten der großen HDDs aus dem weg zu gehen. Bisher bin ich damit ganz gut gefahren.

Ich bin Hitachi gegenüber sehr skeptisch, was auch an deren Produkt Strategie z. B. Helum zu verwenden betrifft, gleiches gilt auch für das "Shingle Magnetic Recording" da betrifft es aber primär die Performance und weniger die Sicherheit/Haltbarkeit.

Ich hatte gehofft das endlich die Mechanik aus dem HDD-Gehäuse verbannt wird und per Laser die Daten Übertragung massiv erhöht wird.

achso, du hast in deinem desktop-rechner 40 platten auf engstem raum. na dann ...außer man strebt einen 24/7 Betrieb ohne Idle an.

hatten wir den sinn der bei behardware veröffentlichten zahlen nicht schon mal früher diskutiert?Die Bisher veröffentlichten Zahlen Sprechen meist eher gegen Hitachi:

http://www.planet3dnow.de/vbulletin...e-3TB-Platte?p=4878076&viewfull=1#post4878076

http://www.planet3dnow.de/vbulletin...interessant!?p=4351993&viewfull=1#post4351993

hgst ist eine tochter von western digital. die produzieren meines wissens zwar immer noch in ihren eigenen fabs, aber geh mal davon aus, dass sich wd und hgst in sachen forschung & entwicklung nicht mehr unterscheiden.Wenn die anderen Hersteller es nicht verbocken sollte man Hitachi in diesen Punkten schlagen können.

in bezug auf hgst? smr haben doch alle verbliebenen hersteller in der pipeline.gleiches gilt auch für das "Shingle Magnetic Recording"

ist das so? hast du irgendwelche zahlen, die belegen, dass mehr platter mit einer geringeren datendichte zu einer höheren ausfallwahrscheinlich führen als weniger platter mit höheren datendichten, komplexeren s/l-köpfen, geringeren flughöhen und einer höheren anforderung an die positionierungsmechanik, also den head stack (also actuator, aufhängung, köpfe usw.)?Zumal auch die Ausfallrate mit steigender Anzahl an Plattern steigt und Hitachi immer min. ein Plattern mehr benötigt hat man Nachteile bei:

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Um Gottes willen, nicht schon wieder diese Rücksende-Statistik dieser Franzosen. Das ist wohl die schlechteste Quelle die man heranziehen kann.

bbott

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 4.363

- Renomée

- 60

- Mein Laptop

- HP Compaq 8510p

- Details zu meinem Desktop

- Prozessor

- AMD FX-8370

- Mainboard

- Asus M5A99X

- Kühlung

- Corsair H60

- Speicher

- 16GB DDR3-1866 Crucial

- Grafikprozessor

- Sapphire HD5770

- Display

- 4k 27" DELL

- SSD

- Samsung Evo 850

- HDD

- 2x Seagate 7200.12

- Optisches Laufwerk

- Pioneer, Plextor

- Soundkarte

- Creative X-Fi Xtreme Music

- Gehäuse

- Silverstone TJ-02S

- Netzteil

- Enermax 450W

- Betriebssystem

- Windows 7

achso, du hast in deinem desktop-rechner 40 platten auf engstem raum. na dann ...

Meine Aussage nicht verstanden? Ich habe gemeint das die oben Herausgegebene Statistik wenig über den Betrieb als Home Desktopplatte aussagt:

Meine Aussage nicht verstanden? Ich habe gemeint das die oben Herausgegebene Statistik wenig über den Betrieb als Home Desktopplatte aussagt:a) Sehr wahrscheinlich weniger Sping up/downs

b) Temp unterscheide

c) 24/7 Betrieb

d) Schwingungen...

Wenn man eine NAS Platte sucht ist es maximal eine Tendenz...

hatten wir den sinn der bei behardware veröffentlichten zahlen nicht schon mal früher diskutiert?

http://www.planet3dnow.de/vbulletin...e-3TB-Platte?p=4878076&viewfull=1#post4878076

http://www.planet3dnow.de/vbulletin...interessant!?p=4351993&viewfull=1#post4351993

Ich habe nicht alles Verfolgt, aber wenn ein Händler die Reklamationen von Kunden angibt ist das für den Desktopbetrieb aussagefähiger, als eine Statistik über Zweckentfremdete Desktopplatten.

hitachi ist eine tochter von western digital. die produzieren meines wissens zwar immer noch in ihren eigenen fabs, aber geh mal davon aus, dass sich wd und hgst in sachen forschung & entwicklung nicht mehr unterscheiden.

Sicher? Es gibt keine Quellen, oder? Selbst von (größeren) Entlassungen habe ich nichts gehört, evtl. nutzt man diese Kapazitäten um einen Technologie-Vorsprung zu Seagate zu erarbeiten. Außerdem schließt man die F&E nicht gleich sondern Transferiert erst das Know-How nach WD was wohl ein paar Gen an HDDs dauern dürfte. Auch werden nicht alle Arbeitsverträge sofort auf kündbar gewesen sein, oder haben gar keinen Kündigungsschutz?!

Da aber der Aufbau immer sich immer noch Unterscheidet (Anzahl Plattern) gehe ich davon aus das die F&E (noch) Existiert. Auch die Aufteilung HSGT erst Helium und WD erst srm spricht für eher zwei F&E.

in bezug auf hgst? smr haben doch alle verbliebenen hersteller in der pipeline.

Das war ein allgemeines Missbilligen der Festplattenentwicklung der letzten Jahre, mehr Plattern und die Nachteile die durch smr entstehen. Wobei ich Heluim als kritischer erachte und das kam als erstes von HGST

ist das so? hast du irgendwelche zahlen, die belegen, dass mehr platter mit einer geringeren datendichte zu einer höheren ausfallwahrscheinlich führen als weniger platter mit höheren datendichten, komplexeren s/l-köpfen, geringeren flughöhen und einer höheren anforderung an die positionierungsmechanik, also den head stack (also actuator, aufhängung, köpfe usw.)?

Wenn man sich die Statistik einer Baureihe anschaut steigt mir Anzahl der Plattern die Ausfallwahrscheinlichkeit, das liegt auch in der Sache der Natur. Der Motor wird stärker belastet, es es mehr Schwungmasse -> mehr Vibrationen und mehr Köpfe, Luftverwirbelung usw. und das ganze dichter gestapelt. HSTG hat es im Vergleich zu den anderen Herstellern aber offensichtlich besser im Griff, da sie i. d. R. Platten mit mehr Plattern anbieten (müssen).

Um Gottes willen, nicht schon wieder diese Rücksende-Statistik dieser Franzosen. Das ist wohl die schlechteste Quelle die man heranziehen kann.

Aber die hier gepostete Statistik ist Aussage fähiger?!

U. a. sind die Zeiträume bzw. das alter der Platten ist absolut unvergleichbar. Wer sagt den das nicht alle HSTG Platten in dem nächsten 1/2 ab rauchen?! Vor allem weil HSTG schon mal geschafft hatte Ausfallraten von 75-90% zu fabrizieren.

Erschwerend kommt hinzu das die Hitachi (z. B. die Hitachi HDS722020ALA330) Platten für den 24/7 Betrieb von Hitachi freigegeben sind!

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Also zunächst einmal werden diese Desktop Festplatten zumeist in NAS Systemen verwendet und nicht so sehr in Single Desktop Systemen. Speziell ist die WD RED 3 TB spezifisch für NAS konzipiert.

Und zweitens nur ein Beispiel:

Freund:"Hey hab eine neue Festplatte gekauft. War online ein Schnäppchen!"

PCNerd:"was hast denn gekauft?"

Freund:"Eine Hitachi"

PCNerd:"Also ich schwöre auf WD, da ist mir noch keine abgeraucht"

Freund:"hmmm..und jetzt?"

PCNerd:"Schick sie zurück, und bestell die WD, die ist auch 10,- € günstiger."

Rücksendung.

Versanddefekt?

Rücksendung

Inhalt unvollständig?

Rücksendung

Also eine Ausfallstatistik mit exakt beschriebenen Umständen werte ich da um ein vielfaches höher als den Rückschluß auf defekte anhand von Rücksendungen. Besonders, wenn man in die Rücksendestatistik lediglich die ersten 6-12 Monate einfließen lässt nach Produktverkauf.

http://www.behardware.com/articles/881-1/components-returns-rates-7.html

Und wer schickt noch HDDs an den Händler nachdem die Gewährleistung vorbei ist?

Und zweitens nur ein Beispiel:

Freund:"Hey hab eine neue Festplatte gekauft. War online ein Schnäppchen!"

PCNerd:"was hast denn gekauft?"

Freund:"Eine Hitachi"

PCNerd:"Also ich schwöre auf WD, da ist mir noch keine abgeraucht"

Freund:"hmmm..und jetzt?"

PCNerd:"Schick sie zurück, und bestell die WD, die ist auch 10,- € günstiger."

Rücksendung.

Versanddefekt?

Rücksendung

Inhalt unvollständig?

Rücksendung

Also eine Ausfallstatistik mit exakt beschriebenen Umständen werte ich da um ein vielfaches höher als den Rückschluß auf defekte anhand von Rücksendungen. Besonders, wenn man in die Rücksendestatistik lediglich die ersten 6-12 Monate einfließen lässt nach Produktverkauf.

http://www.behardware.com/articles/881-1/components-returns-rates-7.html

Zudem weiter oben auf der ersten Seite:The returns rates given concern the products sold between October 1st 2011 and April 1st 2012 for returns made before October 2012, namely after between 6 months and a year of use. Over the lifetime of a product the returns generally form a spread out U on the graph, with the end virtually flat. Our figures therefore cover the early part of the lifetime of products, where returns rates are high.

Der Support sagt zurück schicken, weil am Telefon nicht zu klären oder zu lösen. Austausch weil billiger als 30 min. Support am Telefon.Among the returns that aren’t tested, some of the components announced as having an issue by customers probably aren't actually defective, in spite of the precautions taken by the technician. This is something inherent in the etailing sector and in practice, it’s unlikely that any model or product is more affected by this phenomenon than any other (at least we’re aware of no objective argument that shows this).

Und wer schickt noch HDDs an den Händler nachdem die Gewährleistung vorbei ist?

Hier spielt auch die Herstellergarantie gar keine Rolle und es wird auch nicht erfasst was Aufgrund der Garantie direkt mit dem Hersteller abgewickelt wird.Of course, these statistics are limited to the products sold by this particular etailer and the returns made to it. Sometimes returns are made to the manufacturer itself, particularly with storage but this represents a minority in the first year.

Zuletzt bearbeitet:

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Also die Daten sind dort mehrfach gespiegelt. Wenn du meinst RAID beugt Datenverlust vor, dann bist du schlecht informiert. Das ist kein Backup und keine Duplizierung der Daten. Bei RAID gehts ausschließlich um Datenverfügbarkeit. Und für 5$ im Monat unbegrenztes Online Backup ist ein starker Preis. Ein NAS, eine Remote Duplizierung dorthin und man hat die Daten günstig ausgelagert ausser Haus. Schließt der Anbieter sucht man sich eine andere Backuplösung. Hat man die Dateien verschlüsselt, dann interessiert auch nicht welcher Inhalt hoch geladen wird.

Du hättest dir die Quellen wenigstens ansehen sollen...

Du hättest dir die Quellen wenigstens ansehen sollen...

bbott

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 4.363

- Renomée

- 60

- Mein Laptop

- HP Compaq 8510p

- Details zu meinem Desktop

- Prozessor

- AMD FX-8370

- Mainboard

- Asus M5A99X

- Kühlung

- Corsair H60

- Speicher

- 16GB DDR3-1866 Crucial

- Grafikprozessor

- Sapphire HD5770

- Display

- 4k 27" DELL

- SSD

- Samsung Evo 850

- HDD

- 2x Seagate 7200.12

- Optisches Laufwerk

- Pioneer, Plextor

- Soundkarte

- Creative X-Fi Xtreme Music

- Gehäuse

- Silverstone TJ-02S

- Netzteil

- Enermax 450W

- Betriebssystem

- Windows 7

Die Seagates aber nicht! Die Reds und die Hitachi sind 24/7 PlattenAlso zunächst einmal werden diese Desktop Festplatten zumeist in NAS Systemen verwendet und nicht so sehr in Single Desktop Systemen. Speziell ist die WD RED 3 TB spezifisch für NAS konzipiert.

Und zweitens nur ein Beispiel:

Freund:"Hey hab eine neue Festplatte gekauft. War online ein Schnäppchen!"

PCNerd:"was hast denn gekauft?"

Freund:"Eine Hitachi"

PCNerd:"Also ich schwöre auf WD, da ist mir noch keine abgeraucht"

Freund:"hmmm..und jetzt?"

PCNerd:"Schick sie zurück, und bestell die WD, die ist auch 10,- € günstiger."

Rücksendung.

Ich kenne keinen und aber das auch von keinem Gehört die HDD deswegen zu tauschen lohnt auch nicht wegen den Versandkosten. Und die Qualitäts-Unterscheide sind nicht so Unterschiedlich das es das rechtfertigen würde, von den Performance unterscheiden ganz abgesehen.

Soweit ich weiß wurde auch das die 14-tägie Rückgabe herausgenommen wurde, ergo fällt diese Beispiel flach.

Versanddefekt?

Rücksendung

1. Alle HDDs durchlaufen den selben Versand vom Händler

2. Ein defekt kann auch mangelde Endqualitätskontrolle bedeuten, ergo Hersteller ist daran schuld.

3. 14-tägie Rückgabe wurde herausgenommen

Inhalt unvollständig?

Rücksendung

Was ist Inhalt unvollständig

Egal, 14-tägie Rückgabe wurde herausgenommen

Egal, 14-tägie Rückgabe wurde herausgenommenAlso eine Ausfallstatistik mit exakt beschriebenen Umständen werte ich da um ein vielfaches höher als den Rückschluß auf defekte anhand von Rücksendungen. Besonders, wenn man in die Rücksendestatistik lediglich die ersten 6-12 Monate einfließen lässt nach Produktverkauf.

http://www.behardware.com/articles/881-1/components-returns-rates-7.html

Es müssten u. a. alle Platten im gleichen:

- Rechenzentrum

- Gleichen Rack

- Gleicher Server Typ

- Gleicher Hardware

betreiben worden sein.

Wer sagt denn das der erhöhte Ausfall nicht auf einen Notspot im Rechenzentrum zurück zuführen ist?! Das eine realistische Aussage über die Ausfall wahrschenlichkeit gegeben werden kann zeigt doch schon:

Hitachi (24/7) vs. Seagate (8/7)

Es wird eine halbe Server Platte (24/7 + ggf. weniger Vibration) gegen eine Desktop platte verglichen. Hallo?!

Zudem weiter oben auf der ersten Seite:

Der Support sagt zurück schicken, weil am Telefon nicht zu klären oder zu lösen. Austausch weil billiger als 30 min. Support am Telefon.

Die 08/15 oder DAU User also über 95% geht zum Händler wenn etwas nicht Funktioniert und nicht zum Hersteller.

Das ist der Normale weg nur "Freaks" wie du sie nennst wissen es besser und gehen zum Hersteller.

Und wer schickt noch HDDs an den Händler nachdem die Gewährleistung vorbei ist?

Macht auch keine Sinn nach der Gewährleistung die Platte zu verschicken höchstens nach den 6 Monaten Garantie

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Welche DAUs bestellen Festplatten online? Auf jeden Fall sind Rückläufer keine Defekte. Und die Zahlen völlig verwässert durch den Zeitrahmen 6-12 Monate.

--- Update ---

--- Update ---

Herstellergarantie ist üblicherweise 3 Jahre (z.B. WD Red). Händler Gewährleistung in D 6 Monate.Macht auch keine Sinn nach der Gewährleistung die Platte zu verschicken höchstens nach den 6 Monaten Garantie

alles klar, da werde ich dir nicht widersprechen.Meine Aussage nicht verstanden? Ich habe gemeint das die oben Herausgegebene Statistik wenig über den Betrieb als Home Desktopplatte aussagt:

a) Sehr wahrscheinlich weniger Sping up/downs

b) Temp unterscheide

c) 24/7 Betrieb

d) Schwingungen...

ne, die statistiken sind beide relativ wertlos. nur weil die eine näher am desktop-einsatz ist, heißt das ja noch nicht, dass die daten deshalb irgendeine großartige aussagekraft haben. du hast halt eine inhaltsleere zahl und nicht mehr. in dem verlinkten thread hat cleric das schön zusammengefasst.Ich habe nicht alles Verfolgt, aber wenn ein Händler die Reklamationen von Kunden angibt ist das für den Desktopbetrieb aussagefähiger, als eine Statistik über Zweckentfremdete Desktopplatten.

Ich weiß nun zufällig, wie gelegentlich Reklamationen abgewickelt werden. Das wird im Artikel nebenbei auch erwähnt. Sind denn alle Reklamationen auch tatsächlich defekt? Ich habe erlebt, dass in bestimmten Situationen Reklamationen gar nicht geprüft, sondern direkt an die Distribution oder den Hersteller weitergereicht wurden. Ich weiß auch, dass Reklamationen bei bestimmten Kunden und bestimmten Produkten eher durchgewunken werden als bei anderen. Das könnte man hier noch endlos fortführen.

Aber einmal am Beispiel der Seagate Constellation ES ST2000NM0011, da sagen mir die Daten von Hardware.fr nun folgendes:

Im Erhebungszeitraum sind 9,64% einer unbekannten verkauften Menge (>100) von irgendwelchen Kunden bei irgendeinem Händler aus irgendeinem Grund reklamiert worden.

ich meinte übrigens hgst und nicht hitachi.Da aber der Aufbau immer sich immer noch Unterscheidet (Anzahl Plattern) gehe ich davon aus das die F&E (noch) Existiert. Auch die Aufteilung HSGT erst Helium und WD erst srm spricht für eher zwei F&E.

ansonsten hab ich mich da vielleicht mißverständlich ausgedrückt. hgst arbeitet meines wissens immer noch als relativ selbstständige tochter. das gilt auch für r&d. was ich meinte, das ist der umstand, dass wd selbstständlich zugriff auf sämtliche hgst-entwicklungen hat und umgekehrt. dass technologien zeitverstetzt oder gar exklusiv zum einsatz kommen, dürfte u.a. damit zu tun haben, dass wd und hgst teilweise unterschiedliche marktsegmente addressieren. wd selbst ist nachwievor stark im privatkundengeschäft, während hgst sich vor allem auf den server-bereich fokussiert. das liegt auch ein wenig in der tradition der beiden hersteller begründet. wd hat vor ganz langer zeit den server-bereich quasi aufgegeben und sich erst in den letzten jahren wieder mit spezialisierten produkten rangetastet. scsi/sas- bzw. professionelle server-produkte hatte wd zuletzt in den 90iger jahren im angebot. bei ibm bzw. hgst war das hingegen schon immer eine wichtige säule.

ansonsten hab ich mich da vielleicht mißverständlich ausgedrückt. hgst arbeitet meines wissens immer noch als relativ selbstständige tochter. das gilt auch für r&d. was ich meinte, das ist der umstand, dass wd selbstständlich zugriff auf sämtliche hgst-entwicklungen hat und umgekehrt. dass technologien zeitverstetzt oder gar exklusiv zum einsatz kommen, dürfte u.a. damit zu tun haben, dass wd und hgst teilweise unterschiedliche marktsegmente addressieren. wd selbst ist nachwievor stark im privatkundengeschäft, während hgst sich vor allem auf den server-bereich fokussiert. das liegt auch ein wenig in der tradition der beiden hersteller begründet. wd hat vor ganz langer zeit den server-bereich quasi aufgegeben und sich erst in den letzten jahren wieder mit spezialisierten produkten rangetastet. scsi/sas- bzw. professionelle server-produkte hatte wd zuletzt in den 90iger jahren im angebot. bei ibm bzw. hgst war das hingegen schon immer eine wichtige säule.24/7 alleine sagt nicht viel aus. entscheidend ist eher, für was für ein lastszenario die platten ausgelegt sind. und hitachis desktop-platten sind halt 24/7 für desktop-szenarien, also für low-duty-cycle, ausgelegt und nicht für dauerstress in einem datacenter.Erschwerend kommt hinzu das die Hitachi (z. B. die Hitachi HDS722020ALA330) Platten für den 24/7 Betrieb von Hitachi freigegeben sind!

irgendwie haben wir diese ganze diskussion schon mal geführt.Wenn man sich die Statistik einer Baureihe anschaut steigt mir Anzahl der Plattern die Ausfallwahrscheinlichkeit, das liegt auch in der Sache der Natur. Der Motor wird stärker belastet, es es mehr Schwungmasse -> mehr Vibrationen und mehr Köpfe, Luftverwirbelung usw. und das ganze dichter gestapelt.

http://www.planet3dnow.de/vbulletin...estplatte-an?p=4671849&viewfull=1#post4671849

was du schreibst, kann ich so nicht ganz unterschreiben. natürlich hast du bedingt durch den aufbau bei mehr datenscheiben auch tendenziell mehr verschleiß. das betrifft aber erstmal große bzw. die jeweils größten festplatten, wo schlicht und ergreifend auch mehr datenscheiben zum einsatz kommen. wo die hersteller aber in der regel auch einen höheren aufwand zur kompensation negativer effekte betreiben.

wenn ich allerdings eine gegebene kapazität nehme, kann ich nicht nachvollziehen, warum eine 2tb festplatte mit 2 datenscheiben haltbarer sein soll als eine vergleichbare 2tb festplatte mit 3 datenscheiben. denn in sachen verschleiß und zuverlässigkeit gibt es noch ganz andere faktoren neben dem platten-stapel und dem motor.

nach deiner logik wären also festplatten mit einer höheren datendichte automatisch besser. im gegenteil konnte man in der vergangenheit eher beobachten, dass gerade beim arbeiten an der superparamagnetischen grenze die ganze trickserei, eine komplexere mechanik usw. eher zu problemen bei neuen produkten geführt haben als die verwendung von mehr datenscheiben. der aufwand zur erhöhung der datendichte ist halt immer mehr und immer unverhältnismäßiger gestiegen. und hat zuletzt solche krücken-lösungen wie smr hervorgebracht.

na super, wer so tief in der mottenkiste gräbt und das auch noch alle jahre wiederholt, den kann ich nicht wirklich ernst nehmen.Vor allem weil HSTG schon mal geschafft hatte Ausfallraten von 75-90% zu fabrizieren.

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

SPINA

Grand Admiral Special

- Mitglied seit

- 07.12.2003

- Beiträge

- 18.122

- Renomée

- 985

- Mein Laptop

- Lenovo IdeaPad Gaming 3 (15ARH05-82EY003NGE)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- ASUS PRIME X370-PRO

- Kühlung

- AMD Wraith Prism

- Speicher

- 2x Micron 32GB PC4-25600E (MTA18ASF4G72AZ-3G2R)

- Grafikprozessor

- Sapphire Pulse Radeon RX 7600 8GB

- Display

- LG Electronics 27UD58P-B

- SSD

- Samsung 980 PRO (MZ-V8P1T0CW)

- HDD

- 2x Samsung 870 QVO (MZ-77Q2T0BW)

- Optisches Laufwerk

- HL Data Storage BH16NS55

- Gehäuse

- Lian Li PC-7NB

- Netzteil

- Seasonic PRIME Gold 650W

- Betriebssystem

- Debian 12.x (x86-64)

- Verschiedenes

- ASUS TPM-M R2.0

Mit der höheren Datendichte steigen zwar die maximalen Transferraten an, aber die Latenzzeiten leiden im Gegenzug in der Mehrzahl der Fälle.- Performance (Datenübertragunsrate und Latzenz)

Das ist zutreffend; und kann gar nicht oft genug wiederholen werden, weil der Sinn und Zweck eines RAIDs von vielen Nutzern missverstanden wird.Bei RAID gehts ausschließlich um Datenverfügbarkeit.

PS: Hitachi ist bei der Fertigung selten hinterher gehinkt und hat bei der Datendichte immer vorne mitgespielt. Insbesondere mit den Travelstars.

bbott

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 4.363

- Renomée

- 60

- Mein Laptop

- HP Compaq 8510p

- Details zu meinem Desktop

- Prozessor

- AMD FX-8370

- Mainboard

- Asus M5A99X

- Kühlung

- Corsair H60

- Speicher

- 16GB DDR3-1866 Crucial

- Grafikprozessor

- Sapphire HD5770

- Display

- 4k 27" DELL

- SSD

- Samsung Evo 850

- HDD

- 2x Seagate 7200.12

- Optisches Laufwerk

- Pioneer, Plextor

- Soundkarte

- Creative X-Fi Xtreme Music

- Gehäuse

- Silverstone TJ-02S

- Netzteil

- Enermax 450W

- Betriebssystem

- Windows 7

Mit der höheren Datendichte steigen zwar die maximalen Transferraten an, aber die Latenzzeiten leiden im Gegenzug in der Mehrzahl der Fälle.

Da weniger Schreib-/Lese-Köpfe benötigt werden, sinkt Latenz da seltener die die Umschaltzeit zwischen den Köpfen und die Neupositionierung der Köpfe einen Einfluss hat.

Außerdem werden bei gleicher Datenmenge diese auf weniger Spuren gespeichert, d .h es kann länger auf einer Spur gelesen/geschreiben werden als auch der weg zu nächsten reduziert sich.

Seagate hatte mal eine HDD extra auf ein 1/4 der Äußeren Spuren reduziert, um eine Performance HDD anzubieten, mit niedrigeren Latenzen anzubieten.

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.264

- Renomée

- 1.851

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Das sollte man doch auch so bei jeder HDD hinbekommen, wenn man sich auf den ersten Teil der Platte und somit auf die äußeren Spuren beschränkt.Seagate hatte mal eine HDD extra auf ein 1/4 der Äußeren Spuren reduziert, um eine Performance HDD anzubieten, mit niedrigeren Latenzen anzubieten.

Das mach ich bei meinen HDDs schon seit Jahren so ähnlich. Einfach die Hauptpartition auf 1/2 der Kapazität beschränken, ergibt selbst am langsamsten Ende noch 85% vom Maximum der Datentransferrate.

SPINA

Grand Admiral Special

- Mitglied seit

- 07.12.2003

- Beiträge

- 18.122

- Renomée

- 985

- Mein Laptop

- Lenovo IdeaPad Gaming 3 (15ARH05-82EY003NGE)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- ASUS PRIME X370-PRO

- Kühlung

- AMD Wraith Prism

- Speicher

- 2x Micron 32GB PC4-25600E (MTA18ASF4G72AZ-3G2R)

- Grafikprozessor

- Sapphire Pulse Radeon RX 7600 8GB

- Display

- LG Electronics 27UD58P-B

- SSD

- Samsung 980 PRO (MZ-V8P1T0CW)

- HDD

- 2x Samsung 870 QVO (MZ-77Q2T0BW)

- Optisches Laufwerk

- HL Data Storage BH16NS55

- Gehäuse

- Lian Li PC-7NB

- Netzteil

- Seasonic PRIME Gold 650W

- Betriebssystem

- Debian 12.x (x86-64)

- Verschiedenes

- ASUS TPM-M R2.0

Mit steigender Datendichte wächst die realisierbare Positionierungszeit an. Infolge erzielen HDDs mit mehr Plattern oft höhere IOPS-Werte, weil es durch die gröbere Struktur leichter fällt die angeforderte LBA Adresse anzusteuern. Mit dem kleineren Platterdurchmesser und daraus resultierenden kürzeren Latenzen hast du natürlich Recht. 15K RPM SCSI-Platten haben nicht allein wegen der Kräfte, die durch die hohe Umdrehungszahl entstehen, viel kleinere Platter als ins 3.5" Gehäuse passen. Gleichermaßen dient es der Optimierung auf kurze Antwortzeiten.

PS: Ausserdem greifen alle Köpfe parallel auf die vorhandenen Platter zu. Es muss nicht zwischen ihnen umgeschaltet werden. Ein Block wird demnach "gestripped" gelesen und geschrieben. So multipliziert sich der Durchsatz. Oder worauf möchtest du hinaus?

PS: Ausserdem greifen alle Köpfe parallel auf die vorhandenen Platter zu. Es muss nicht zwischen ihnen umgeschaltet werden. Ein Block wird demnach "gestripped" gelesen und geschrieben. So multipliziert sich der Durchsatz. Oder worauf möchtest du hinaus?

Zuletzt bearbeitet:

ich kenne nun die daten aktueller hdd's nicht, aber da steht halt der head-switch gegenüber track-to-track bzw. der settle-time. und auch wenn sich letzteres in grenzen über die "granularität" des actuators kompensieren lässt, dürfte dem bei den steigenden datendichten grenzen gesetzt sein.Da weniger Schreib-/Lese-Köpfe benötigt werden, sinkt Latenz da seltener die die Umschaltzeit zwischen den Köpfen und die Neupositionierung der Köpfe einen Einfluss hat.

aber das hat auch nichts mehr mit dem thema zuverlässigkeit zu tun.

short-stroke ist nun auch keine erfindung von seagate.Seagate hatte mal eine HDD extra auf ein 1/4 der Äußeren Spuren reduziert, um eine Performance HDD anzubieten, mit niedrigeren Latenzen anzubieten.

bbott

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 4.363

- Renomée

- 60

- Mein Laptop

- HP Compaq 8510p

- Details zu meinem Desktop

- Prozessor

- AMD FX-8370

- Mainboard

- Asus M5A99X

- Kühlung

- Corsair H60

- Speicher

- 16GB DDR3-1866 Crucial

- Grafikprozessor

- Sapphire HD5770

- Display

- 4k 27" DELL

- SSD

- Samsung Evo 850

- HDD

- 2x Seagate 7200.12

- Optisches Laufwerk

- Pioneer, Plextor

- Soundkarte

- Creative X-Fi Xtreme Music

- Gehäuse

- Silverstone TJ-02S

- Netzteil

- Enermax 450W

- Betriebssystem

- Windows 7

Generell sind aber die Latenzen inzwischen deutlich gesunken, im Vergleich zu alten Platten. Beim Umschalten zwischen den Plattern/Köpfen generiert eine Latenz und da die Spuren nicht 100%ig übereinstimmen muss der Lesekopft neu Positioniert werden soweit ich weiß. Das die Leseköpfe parallel zu greifen können ist/wäre mir neu, dann könnte man doch auch die Lese-Geschwindigkeit um Faktor X erhöhen.

Cleric

Admiral Special

- Mitglied seit

- 08.01.2003

- Beiträge

- 1.087

- Renomée

- 110

Das wäre mir neu. Was sagt denn die Head-Switch-Time aus, die die Hersteller spezifizieren? Und dann müsste die Transferrate eines 5-Platter-Modells entsprechend 5x so hoch ausfallen wie die eines 1-Platters-Modells.PS: Ausserdem greifen alle Köpfe parallel auf die vorhandenen Platter zu. Es muss nicht zwischen ihnen umgeschaltet werden. Ein Block wird demnach "gestripped" gelesen und geschrieben. So multipliziert sich der Durchsatz. Oder worauf möchtest du hinaus?

GenauDas die Leseköpfe parallel zu greifen können ist/wäre mir neu, dann könnte man doch auch die Lese-Geschwindigkeit um Faktor X erhöhen.

Leider sind technische Dokumentationen bei den diversen Herstellern inzwischen Mangelware. Aber die Head-Switch-Time war bei HGST-Modellen der jüngeren Vergangenheit immer relativ konstant gewesen. Ebenso der Single-Track-Seek inkl. Settle-Time (steht auch heute noch in den Datenblättern), wobei es hier immer mal wieder Abweichungen gibt. Aber offenbar hat man die Positionierung auch bei steigender Datendichte ganz gut im Griff. Aber bei modernen Festplatten hat der Faktor des reinen physikalischen Zugriffs ohnehin an Bedeutung verloren, da zählen mehr intelligente Cache- und Read-Ahead Algorithmen, NCQ und der ganze Kram.Generell sind aber die Latenzen inzwischen deutlich gesunken, im Vergleich zu alten Platten.

bbott

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 4.363

- Renomée

- 60

- Mein Laptop

- HP Compaq 8510p

- Details zu meinem Desktop

- Prozessor

- AMD FX-8370

- Mainboard

- Asus M5A99X

- Kühlung

- Corsair H60

- Speicher

- 16GB DDR3-1866 Crucial

- Grafikprozessor

- Sapphire HD5770

- Display

- 4k 27" DELL

- SSD

- Samsung Evo 850

- HDD

- 2x Seagate 7200.12

- Optisches Laufwerk

- Pioneer, Plextor

- Soundkarte

- Creative X-Fi Xtreme Music

- Gehäuse

- Silverstone TJ-02S

- Netzteil

- Enermax 450W

- Betriebssystem

- Windows 7

Das wäre mir neu. Was sagt denn die Head-Switch-Time aus, die die Hersteller spezifizieren? Und dann müsste die Transferrate eines 5-Platter-Modells entsprechend 5x so hoch ausfallen wie die eines 1-Platters-Modells.

Eine um Faktor 10(!) oder und Unterseite

Eine Seagate 7200.14 mit max. ~200MB/s käme somit auf 2.000MB/s bei gleichzeitig fallender Latenz, da die köpfe weniger Spuren suchen müssen

Damit würden HDDs den SATA 6.0 überfordern und in Sachen, Datenübertagung mit SSDs übertrumpfen/konkurrieren können.

--- Update ---

irgendwie haben wir diese ganze diskussion schon mal geführt.

http://www.planet3dnow.de/vbulletin...estplatte-an?p=4671849&viewfull=1#post4671849

was du schreibst, kann ich so nicht ganz unterschreiben. natürlich hast du bedingt durch den aufbau bei mehr datenscheiben auch tendenziell mehr verschleiß. das betrifft aber erstmal große bzw. die jeweils größten festplatten, wo schlicht und ergreifend auch mehr datenscheiben zum einsatz kommen. wo die hersteller aber in der regel auch einen höheren aufwand zur kompensation negativer effekte betreiben.

Da müsste ich die wieder auf die Ausfallraten des Händlers verweisen, weitere Quellen habe ich gerade nicht zu Hand. Dort wird aber meist den HDDs mit den großen Anzahl von Plattern meist eine doppelt so hohe Ausfall Wahrscheinlichkeit aufgezeigt.

Fast immer werden aber eben nicht extra Motoren verbaut und/oder weitere Genmaßnahmen ergriffen, das kostet (unnötig) Geld. Selbst wenn sie die Motoren nutzen, sind sie nicht so aus getestet getestet oder vertragen weniger Spin-ups/-downs etc. Das diese "großen" Motoren weniger getestet sind daran das diese Platten deutlich weniger verkauft werden, als die "kleinen".

Die Samsung SP1614C/P ist da ein relativ gutes Beispiel es gab diese mit zwei unterschiedliche Motoren, der eine wies eine relativ hohe Ausfall Wahrscheinlichkeit, der andere läuft bei mir noch heute.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

AUSFALLRATEN sind etwas völlig anderes als Rücksenderaten. Das sollte dir doch wohl mittlerweile klar sein. Ein Händler kennt keine Ausfallraten.Da müsste ich die wieder auf die Ausfallraten des Händlers verweisen,

Ähnliche Themen

- Antworten

- 0

- Aufrufe

- 52K

- Antworten

- 0

- Aufrufe

- 377K

- Antworten

- 0

- Aufrufe

- 354K