App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

AMD Zen - 14nm, 8 Kerne, 95W TDP & DDR4?

- Ersteller UNRUHEHERD

- Erstellt am

Crashtest

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2008

- Beiträge

- 9.275

- Renomée

- 1.413

- Standort

- Leipzig

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- Collatz, yoyo, radac

- Lieblingsprojekt

- yoyo

- Meine Systeme

- Ryzen: 2x1600, 5x1700, 1x2700,1x3600, 1x5600X; EPYC 7V12 und Kleinzeuch

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Lenovo IdeaPad 5 14ALC05

- Details zu meinem Desktop

- Prozessor

- Ryzen 7950X / Ryzen 4750G

- Mainboard

- ASRock B650M PGRT / X570D4U

- Kühlung

- be quiet! Dark Rock Pro4 / Pure Rock Slim 2

- Speicher

- 64GB DDR5-5600 G Skill F5-5600J3036D16G / 32 GB DDR4-3200 ECC

- Grafikprozessor

- Raphael IGP / ASpeed AST-2500

- Display

- 27" Samsung LF27T450F

- SSD

- KINGSTON SNVS2000G

- HDD

- - / 8x Seagate IronWolf Pro 20TB

- Optisches Laufwerk

- 1x B.Ray - LG BD-RE BH16NS55

- Soundkarte

- onboard HD?

- Gehäuse

- zu kleines für die GPU

- Netzteil

- be quiet! Pure Power 11 400W / dito

- Tastatur

- CHERRY SECURE BOARD 1.0

- Maus

- Logitech RX250

- Betriebssystem

- Windows 10 19045.3996 / Server 20348.2227

- Webbrowser

- Edge 120.0.2210.121

- Verschiedenes

- U320 SCSI-Controller !!!!

- Internetanbindung

- ▼1000 MBit ▲82 MBit

Wenns auf deinem Konto so knapp aussieht, denk lieber an was kleineres.

Sonst bleibt dir demnächst noch viel Monat am Ende vom Geld über

Naja wenn am Freitag noch für dem Preis in Laden dann ich kaufen tu, nur derzeit reicht das (Rest)Geld ohne Lohn noch nicht weil andere Anschaffungen für Pentadings gerade laufen

grauenvoll

Cadet

- Mitglied seit

- 08.01.2017

- Beiträge

- 50

- Renomée

- 1

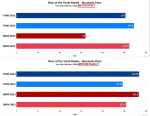

Ryzen schwache Performance bei Rise of Tomb Raider genauer betrachtet:

Ab Minute 10 wird es interessant...

Daraus kann man schließen:

- Ryzen wird von Vega stark profitieren.

- Ein Blick auf MutliGPU lohnt. (Wird leider zu wenig getestet).

Ab Minute 10 wird es interessant...

Daraus kann man schließen:

- Ryzen wird von Vega stark profitieren.

- Ein Blick auf MutliGPU lohnt. (Wird leider zu wenig getestet).

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.336

- Renomée

- 1.973

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Es sieht einfach so aus als würde der Geforce Treiber Beim Ryzen mit SMT zumindest bei DX12 eine falsche Kernzuordnung nutzen und 2 Threads auf einen Kern bappen. Das dies leistungstechnisch voll nach hinten los geht ist nun wirklich nichts neues.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.224

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Evt. sollten wir unterscheiden zwischen Software, OS und Hardware Threads.Es sieht einfach so aus als würde der Geforce Treiber Beim Ryzen mit SMT zumindest bei DX12 eine falsche Kernzuordnung nutzen und 2 Threads auf einen Kern bappen. Das dies leistungstechnisch voll nach hinten los geht ist nun wirklich nichts neues.

Durch die "low level" Programmierung ist man inzwischen als Entwickler relativ unabhängig.

Sprich, wenn die Engine schon auf mehr Threads ausgelegt ist, wirkt es sich auch über all dort aus, wo genug Hardware vorhanden ist.

Was das OS dann macht, dient eher dem Turbo.

Worauf ich hinaus möchte, wenn ein Software Entwickler alle Ressourcen nutzen will, dann soll sie/er das doch "dürfen" !?

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.336

- Renomée

- 1.973

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Bei der Problematik hilft aber "mehr threads" alleine nicht weiter denn wenn die beiden virtuellen Kerne auf einem Kern laufen ist das im Vergleich zu 2 getrennten Kernen ein massiver Leistungseinbruch und genau danach sieht es für mich aus. AMD wurde ja in der Vergangenheit dafür kritisiert das sie SMT bei ihren Treibern nicht verwenden, gut möglich das ausgerechnet dieser Umstand jetzt für die deutliche Mehrleistung bei DX12 mit verantwortlich ist.

Es kann aber auch sein das nvidia ihren Treiber recht starr auf die HTT Kernverteilung ausgerichtet hat, was bei einer anderen Verteilung bei AMDs SMT Umsatzung zwangsläufig in die Hose gehen würde.

Es kann aber auch sein das nvidia ihren Treiber recht starr auf die HTT Kernverteilung ausgerichtet hat, was bei einer anderen Verteilung bei AMDs SMT Umsatzung zwangsläufig in die Hose gehen würde.

grauenvoll

Cadet

- Mitglied seit

- 08.01.2017

- Beiträge

- 50

- Renomée

- 1

Es sieht einfach so aus als würde der Geforce Treiber Beim Ryzen mit SMT zumindest bei DX12 eine falsche Kernzuordnung nutzen und 2 Threads auf einen Kern bappen. Das dies leistungstechnisch voll nach hinten los geht ist nun wirklich nichts neues.

SMT allein erklärt es nicht. Da muss noch mehr ungeschickt ablaufen. nVidia scheint auch keine große Eile zu haben, das Problem zu lösen.

Meine persönliche Meinung ist, dass nVidia keine große Lust auf DX12 hat. Es passt nicht zu den strategischen Zielen der Company, man kann da schon fast von Boykott reden. Über nVidas rudimentäre und lustlose Implementierung haben sich schon etliche Entwickler beschwert. Manche auch öffentlich. Bisher geht die Strategie aber auf: statt nVidias Treiberarbeit in Frage zu stellen, wird die Schnittstelle an sich als wenig gewinnbringend angesehen.

Zuletzt bearbeitet:

Peet007

Admiral Special

- Mitglied seit

- 30.09.2006

- Beiträge

- 1.883

- Renomée

- 39

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 8700G

- Mainboard

- MSI Mortar B650

- Kühlung

- Wasser

- Speicher

- 32 GB

- Grafikprozessor

- IGP

- Display

- Philips

- Soundkarte

- onBoard

- Netzteil

- 850 Watt

- Betriebssystem

- Manjaro / Ubuntu

- Webbrowser

- Epiphany

DX ist halt auch nur "eine" Schnittstelle von einer Firma. Was eben nur 20% des Softwarmarktes sind. Dann kommt noch hinzu ob AMD die ganze Dokumentation für Ryzen schon veröffentlicht hat und für Nvidia zugänglich ist.

Wenn man nur auf die Youtube Videos geht mit ein bischen Benchmarkgedöns um Klicks zu erhaschen.......

Wenn man nur auf die Youtube Videos geht mit ein bischen Benchmarkgedöns um Klicks zu erhaschen.......

grauenvoll

Cadet

- Mitglied seit

- 08.01.2017

- Beiträge

- 50

- Renomée

- 1

Wenn man nur auf die Youtube Videos geht mit ein bischen Benchmarkgedöns um Klicks zu erhaschen.......

*lach* das ist die Motivation, das zu 90% das Internet mit Inhalten füllt: Klicks zu erhaschen. Die ganze PC-Branche besteht nur aus Benchmarkgedöns... Deswegen jemanden zu diskreditieren ist doch ziemlich daneben.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.336

- Renomée

- 1.973

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

@ grauenvoll

Lasse SMT durch den zweiten virtuellen Kern auf einem physischen Kern im Schnitt 30% Zusatzleistung bringen und wir sind bei ca. 130% bei den beiden virtuellen Kernen. Im Vergleich zu den möglichen 200% auf 2 physischen Kernen mit je einem virtuellen Kern ist das mickrig und ein Einbruch von grob geschätzt 40% und das nur weil die falschen Kerne genutzt werden. Da die Spiele die Kerne idR. ohnehin nicht voll auslasten können und die CPU deshalb Teillast nutzen dürfte dieses Szenario warscheinlicher sein als so manchen lieb ist. Windows mag ja noch mitbekommen was welcher Kern ist, weshalb das Problem bei DX11 Spielen eher selten anzutreffen ist. Müssen die DX12 Spiele große Teile des Shedulings allerdings selbst übernehmen dann kann das schon recht schnell in die hose gehen, zumal es vor dewm Ryzen nur ein Kernverteilungsschema für SMT gab. Richte das Sheduling fest darauf aus und es geht bei einem anderen Schema voll in die Hose.

Lasse SMT durch den zweiten virtuellen Kern auf einem physischen Kern im Schnitt 30% Zusatzleistung bringen und wir sind bei ca. 130% bei den beiden virtuellen Kernen. Im Vergleich zu den möglichen 200% auf 2 physischen Kernen mit je einem virtuellen Kern ist das mickrig und ein Einbruch von grob geschätzt 40% und das nur weil die falschen Kerne genutzt werden. Da die Spiele die Kerne idR. ohnehin nicht voll auslasten können und die CPU deshalb Teillast nutzen dürfte dieses Szenario warscheinlicher sein als so manchen lieb ist. Windows mag ja noch mitbekommen was welcher Kern ist, weshalb das Problem bei DX11 Spielen eher selten anzutreffen ist. Müssen die DX12 Spiele große Teile des Shedulings allerdings selbst übernehmen dann kann das schon recht schnell in die hose gehen, zumal es vor dewm Ryzen nur ein Kernverteilungsschema für SMT gab. Richte das Sheduling fest darauf aus und es geht bei einem anderen Schema voll in die Hose.

grauenvoll

Cadet

- Mitglied seit

- 08.01.2017

- Beiträge

- 50

- Renomée

- 1

Müssen die DX12 Spiele große Teile des Shedulings allerdings selbst übernehmen dann kann das schon recht schnell in die hose gehen, zumal es vor dewm Ryzen nur ein Kernverteilungsschema für SMT gab. Richte das Sheduling fest darauf aus und es geht bei einem anderen Schema voll in die Hose.

Es hat ja einige Tests mit SMT ON/OFF gegeben. Die Effekte lagen meist im einstelligen Prozentbereich. Ausserdem wurde in dem Video untersucht, wie sich die Situation verhält, wenn man nVidas 1070 durch 2x RX480(DX12/MultiGPU) ersetzt.

Wenn ich deiner Logik folge, hätte der Wechsel der Grafikkarten keinen großen Einfluss haben dürfen, denn Raise of Tomb Raider hätte das gleiche SMT Problem bei 2x RX480 haben müssen wie bei einer GTX1070. Dem ist aber nicht so!

Lag Ryzen bei einer GTX1070 und DX12 fast abgeschlagen zurück, ändert sich das Bild bei 2x RX480 komplett.

Zu was Ryzen in der Lage ist, werden wir erst sehen wenn Vega verfügbar ist!

Zuletzt bearbeitet:

MacroWelle

Captain Special

- Mitglied seit

- 15.02.2008

- Beiträge

- 236

- Renomée

- 1

Wer weiß, vielleicht hat Nvidia im Vorfeld keine Ryzen-Samples zum Anpassen ihrer Treiber bekommenDX ist halt auch nur "eine" Schnittstelle von einer Firma. Was eben nur 20% des Softwarmarktes sind. Dann kommt noch hinzu ob AMD die ganze Dokumentation für Ryzen schon veröffentlicht hat und für Nvidia zugänglich ist.

Peet007

Admiral Special

- Mitglied seit

- 30.09.2006

- Beiträge

- 1.883

- Renomée

- 39

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 8700G

- Mainboard

- MSI Mortar B650

- Kühlung

- Wasser

- Speicher

- 32 GB

- Grafikprozessor

- IGP

- Display

- Philips

- Soundkarte

- onBoard

- Netzteil

- 850 Watt

- Betriebssystem

- Manjaro / Ubuntu

- Webbrowser

- Epiphany

Nvidia legt so gut wie nichts offen, was ihre Chips angeht. Das Entwicklungstool von AMD für Linux hat noch keinen Ryzen support.  Als ich das letzte mal nachgesehen haben.

Als ich das letzte mal nachgesehen haben.

Als ich das letzte mal nachgesehen haben.

Als ich das letzte mal nachgesehen haben.sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.336

- Renomée

- 1.973

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

@ grauenvoll

Wenn du meiner Logik folgen würdest dann wäre dir der Aspekt der SMT/CPU Nutzung durch den Treiber in den Sinn gekommen.

Bei den DX11 Treibern wurde AMD stets wegen der schlechteren Leistung kritisiert, welche meiner Erfahrung nach vor allem durch eine schlechtere CPU Auslastung/Kern Nutzung zu stande kam. Diesbezüglich kam ja auch Kritik aus dem Entwickler Lager udn wenn ich mich recht entsinne spielte da auch SMT eine Rolle das vom AMD Treiber nicht genutzt wurde.

Übertrage das mal auf ein fehlerhaftes SMT Ansprechverhalten bei DX12. Wo kein SMT genutzt wird tritt das Problem nicht auf.

Zu den SMT on/off tests, bei wievielen wurde auf die API geachtet?

Es ließe sich ja auch recht einfach nachprüfen indem ein Geforce Besitzer mit einem Ryzen den Test mit und ohne SMT nachstellt.

Steigt sie ohne SMT in normale Regionen ist klar wo der Hund begraben ist.

Wenn du meiner Logik folgen würdest dann wäre dir der Aspekt der SMT/CPU Nutzung durch den Treiber in den Sinn gekommen.

Bei den DX11 Treibern wurde AMD stets wegen der schlechteren Leistung kritisiert, welche meiner Erfahrung nach vor allem durch eine schlechtere CPU Auslastung/Kern Nutzung zu stande kam. Diesbezüglich kam ja auch Kritik aus dem Entwickler Lager udn wenn ich mich recht entsinne spielte da auch SMT eine Rolle das vom AMD Treiber nicht genutzt wurde.

Übertrage das mal auf ein fehlerhaftes SMT Ansprechverhalten bei DX12. Wo kein SMT genutzt wird tritt das Problem nicht auf.

Zu den SMT on/off tests, bei wievielen wurde auf die API geachtet?

Es ließe sich ja auch recht einfach nachprüfen indem ein Geforce Besitzer mit einem Ryzen den Test mit und ohne SMT nachstellt.

Steigt sie ohne SMT in normale Regionen ist klar wo der Hund begraben ist.

Zuletzt bearbeitet:

@ grauenvoll

Wenn du meiner Logik folgen würdest dann wäre dir der Aspekt der SMT/CPU Nutzung durch den Treiber in den Sinn gekommen.

Bei den DX11 Treibern wurde AMD stets wegen der schlechteren Leistung kritisiert, welche meiner Erfahrung nach vor allem durch eine schlechtere CPU Auslastung/Kern Nutzung zu stande kam. Diesbezüglich kam ja auch Kritik aus dem Entwickler Lager udn wenn ich mich recht entsinne spielte da auch SMT eine Rolle das vom AMD Treiber nicht genutzt wurde.

Übertrage das mal auf ein fehlerhaftes SMT Ansprechverhalten bei DX12. Wo kein SMT genutzt wird tritt das Problem nicht auf.

Zu den SMT on/off tests, bei wievielen wurde auf die API geachtet?

Hast du da eine Quelle für? Höre ich so zum ersten mal. Wäre aber aus Sicht AMD`s auch bescheuert, wenn es so wäre nichts dagegen zu tun. Meine Halbwissen meint zu "wissen" dass NV die Drawcalls unter DX11 besser im Griff hat... Wobei eines darf man auch nicht vergessen - NV-Spiele sollte man aus der Betrachtung aussen vor lassen oder zumindest nur Benches anschauen wo NV Effekte aussen vor sind...

SPINA

Grand Admiral Special

- Mitglied seit

- 07.12.2003

- Beiträge

- 18.122

- Renomée

- 985

- Mein Laptop

- Lenovo IdeaPad Gaming 3 (15ARH05-82EY003NGE)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- ASUS PRIME X370-PRO

- Kühlung

- AMD Wraith Prism

- Speicher

- 2x Micron 32GB PC4-25600E (MTA18ASF4G72AZ-3G2R)

- Grafikprozessor

- Sapphire Pulse Radeon RX 7600 8GB

- Display

- LG Electronics 27UD58P-B

- SSD

- Samsung 980 PRO (MZ-V8P1T0CW)

- HDD

- 2x Samsung 870 QVO (MZ-77Q2T0BW)

- Optisches Laufwerk

- HL Data Storage BH16NS55

- Gehäuse

- Lian Li PC-7NB

- Netzteil

- Seasonic PRIME Gold 650W

- Betriebssystem

- Debian 12.x (x86-64)

- Verschiedenes

- ASUS TPM-M R2.0

Leider ist AMD in der Hinsicht nur unwesentlich besser als nVidia. Entweder ist sie nicht öffentlich oder bruchstückhaft.Nvidia legt so gut wie nichts offen, was ihre Chips angeht.

Kommt es einem auf gute Dokumentation an, muss man gezwungenermaßen zum Monopolisten mit dem blauen Logo greifen.

Das kommt früh: Soll mir aber nur recht sein

http://www.tomshardware.de/amd-ryzen7-summit-ridge-zen-preissenkung,news-258009.html

http://www.tomshardware.de/amd-ryzen7-summit-ridge-zen-preissenkung,news-258009.html

BavarianRealist

Grand Admiral Special

- Mitglied seit

- 06.02.2010

- Beiträge

- 3.358

- Renomée

- 80

Das kommt früh: Soll mir aber nur recht sein

http://www.tomshardware.de/amd-ryzen7-summit-ridge-zen-preissenkung,news-258009.html

Der Abstand zwischen den 6- und 8-Kernern dürfte zu groß gewesen sein. All mein Umfeld will sich einen 6-Kerner kaufen; fast allen ist der 8-Kerner zu teuer. Auch ich hole mir den "einfachen" Ryzen-5-1600. Man kann ja dann später auf einen Zen-+ mit 8 Kernen upgraden.

Nachdem die 6- und 8-Kerner auf dem gleichen Die basieren und AMD den Preisabstand reduziert, gehe ich davon aus, dass entweder das Yield der 8-Kerner besser ist als die Nachfrage-Verteilung oder dass der 8-Kerner bisher etwas zu teuer war und man einfach erreichen will, dass mehr Kunden zum teurern Produkt greifen.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.336

- Renomée

- 1.973

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

@ Novasun

Ich hatte mal meine eigene kleine Testreihe mit einer 290x und einer GTX970 auf einem FX-8350 gemacht, welcher aufgrund der relativ geringen Einzelkern leistung eine recht gute Basis für solche Spielchen war.

http://www.planet3dnow.de/vbulletin/threads/425119-R9-290x-vs-GTX970-im-CPU-Last-Vergleich

Die Ergebnisse waren natürlich zum Teil durchwachsen aber beim Star Swarm Stress Test war es doch recht eindeutig erkennbar wo hohe Leistung der Geforce bei DX11 her kam. Das die Radeon voll im CPU Limit hing sieht man ja anhand der deutlich besseren Ergebnisse beim Mantle Test, bei welchem die CPU durch die bessere Lastverteilung auch stärker ausgelastet wurde. Bei der Geforce sieht man ebenfalls eine deutlich bessere Lastverteilung auf den Kernen und damit auch eine höhere Auslastung der CPU. Da ist es auch nicht wirklich verwunderlich das die Geforce dann besser mit Daten versorgt wird und dsie eine höhere Framerate erreicht. Mit der damals umjubelten besseren Effizienz der Treiber hatte das herzlich wenig zu tuen, die vorhandene Hardware wurde nur effektiver genutzt und damit stärker ausgelastet.

Ich hatte mal meine eigene kleine Testreihe mit einer 290x und einer GTX970 auf einem FX-8350 gemacht, welcher aufgrund der relativ geringen Einzelkern leistung eine recht gute Basis für solche Spielchen war.

http://www.planet3dnow.de/vbulletin/threads/425119-R9-290x-vs-GTX970-im-CPU-Last-Vergleich

Die Ergebnisse waren natürlich zum Teil durchwachsen aber beim Star Swarm Stress Test war es doch recht eindeutig erkennbar wo hohe Leistung der Geforce bei DX11 her kam. Das die Radeon voll im CPU Limit hing sieht man ja anhand der deutlich besseren Ergebnisse beim Mantle Test, bei welchem die CPU durch die bessere Lastverteilung auch stärker ausgelastet wurde. Bei der Geforce sieht man ebenfalls eine deutlich bessere Lastverteilung auf den Kernen und damit auch eine höhere Auslastung der CPU. Da ist es auch nicht wirklich verwunderlich das die Geforce dann besser mit Daten versorgt wird und dsie eine höhere Framerate erreicht. Mit der damals umjubelten besseren Effizienz der Treiber hatte das herzlich wenig zu tuen, die vorhandene Hardware wurde nur effektiver genutzt und damit stärker ausgelastet.

Peet007

Admiral Special

- Mitglied seit

- 30.09.2006

- Beiträge

- 1.883

- Renomée

- 39

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 8700G

- Mainboard

- MSI Mortar B650

- Kühlung

- Wasser

- Speicher

- 32 GB

- Grafikprozessor

- IGP

- Display

- Philips

- Soundkarte

- onBoard

- Netzteil

- 850 Watt

- Betriebssystem

- Manjaro / Ubuntu

- Webbrowser

- Epiphany

Was auch noch hinzukommt ist, was für Berechnungen die GPU selber erledigt und was auf die CPU ausgelagert wird. Kann mir durchaus vorstellen das es da gewisse Unterschiede zwischen AMD und Nvidia gibt.

Der Nvidia-Treiber gräbt sich auch tiefer ins System ein. Ich denke mal das sich die Nvidia-Karte mit der CPU "kurzschließt". AMD nutzt wahrscheinlich eine Schnittstelle die eins darüber ist. Also nicht so effizient.

Der Nvidia-Treiber gräbt sich auch tiefer ins System ein. Ich denke mal das sich die Nvidia-Karte mit der CPU "kurzschließt". AMD nutzt wahrscheinlich eine Schnittstelle die eins darüber ist. Also nicht so effizient.

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.336

- Renomée

- 1.973

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Es wurde ja später bekannt das bei nvidia inzwischen viele Sheduling Aufgaben des Grafik Chips, welche bei AMD in Hardware gegossen sind, bei nvidia vom Treiber erledigt werden. Ich weiss aber licht mehr ab welcher Generation das war. War das ab dem Kepler oder erst ab der Maxwell Generation?

Ich gehe mal davon aus das ihr Treiber deshalb diverse Unzulänglichkeiten von DX11 untergraben kann, letztendlich aber auch für die oben angesprochenen Probleme anfällig sein kann.

Ich gucke nochmal nach ob ich was zu der GPU Sheduling Geschichte finde.

--- Update ---

Ich glaube ich hatte die Info von dem Youtube Video hier: https://www.youtube.com/watch?v=nIoZB-cnjc0

Ich gehe mal davon aus das ihr Treiber deshalb diverse Unzulänglichkeiten von DX11 untergraben kann, letztendlich aber auch für die oben angesprochenen Probleme anfällig sein kann.

Ich gucke nochmal nach ob ich was zu der GPU Sheduling Geschichte finde.

--- Update ---

Ich glaube ich hatte die Info von dem Youtube Video hier: https://www.youtube.com/watch?v=nIoZB-cnjc0

Marius87

Fleet Captain Special

- Mitglied seit

- 08.04.2015

- Beiträge

- 294

- Renomée

- 14

- Standort

- Siegen

- Mein Laptop

- HP 15 (AMD A6-7310, Full-HD IPS matt, 8GB DDR3-1600, 500GB SSHD)

- Details zu meinem Desktop

- Prozessor

- AMD FX-6300@4GHz (vorher Phenom II 965BE@3,8GHz, Athlon II X4 640@3,6GHz)

- Mainboard

- ASRock 970 Extreme4

- Kühlung

- GELID Tranquillo Rev. 2

- Speicher

- 8GB Corsair CMX8GX3M2A1600C9

- Grafikprozessor

- AMD Radeon R9 280X

- Display

- Samsung SyncMaster 2433BW

- Webbrowser

- Cyberfox AMD64

Crucial Ballistix Sport BLS2C8G4D240FSE (121,57€ / 121,90€ / 129€ VSKF) läuft Dual Ranked @ 2933 MHz @ AM4 und entspricht damit der Leistung der teuren G.Skill 3200 MHz Single Rank Speicher! (Quelle Rawiioli @Youtube)

Zuletzt bearbeitet:

Mente

Grand Admiral Special

- Mitglied seit

- 23.05.2009

- Beiträge

- 3.671

- Renomée

- 135

- Aktuelle Projekte

- constalation astroids yoyo

- Lieblingsprojekt

- yoyo doking

- Meine Systeme

- Ryzen 3950x

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD 5800X3D

- Mainboard

- Asus ROG Crosshair VIII Dark Hero

- Kühlung

- Headkiller IV

- Speicher

- 3800CL14 G.Skill Trident Z silber/rot DIMM Kit 32GB, DDR4-3600, CL15-15-15-35 (F4-3600C15D-16GTZ)

- Grafikprozessor

- AMD Radeon RX 6900 XT Ref. @Alphacool

- Display

- MSI Optix MAG27CQ

- SSD

- SN8502TB,MX5001TB,Vector150 480gb,Vector 180 256gb,Sandisk extreme 240gb,RD400 512gb

- HDD

- n/a

- Optisches Laufwerk

- n/a

- Soundkarte

- Soundblaster X4

- Gehäuse

- Phanteks Enthoo Pro 2 Tempered Glass

- Netzteil

- Seasonic Prime GX-850 850W

- Tastatur

- Logitech G19

- Maus

- Logitech G703

- Betriebssystem

- Win 10 pro

- Webbrowser

- IE 11 Mozilla Opera

- Verschiedenes

- Logitech PRO RENNLENKRAD DD

Hi naja nicht ganz  da der 3200 Speicher nur mit 2933 lief aber gut zu sehen das Dual Rank auch übertatet werden kann, viele haben ja schon mit den XMP Frequenzen Probleme diese zum laufen zu bekommen.

da der 3200 Speicher nur mit 2933 lief aber gut zu sehen das Dual Rank auch übertatet werden kann, viele haben ja schon mit den XMP Frequenzen Probleme diese zum laufen zu bekommen.

Daher wurden die Samsung B site so gepusht weil die doch gemessen an den anderen die besten Ergebnisse hatten, wenn ich das nur bei mir anschaue die starten sogar mit 3600 CL16.

lg

da der 3200 Speicher nur mit 2933 lief aber gut zu sehen das Dual Rank auch übertatet werden kann, viele haben ja schon mit den XMP Frequenzen Probleme diese zum laufen zu bekommen.

da der 3200 Speicher nur mit 2933 lief aber gut zu sehen das Dual Rank auch übertatet werden kann, viele haben ja schon mit den XMP Frequenzen Probleme diese zum laufen zu bekommen.Daher wurden die Samsung B site so gepusht weil die doch gemessen an den anderen die besten Ergebnisse hatten, wenn ich das nur bei mir anschaue die starten sogar mit 3600 CL16.

lg

Marius87

Fleet Captain Special

- Mitglied seit

- 08.04.2015

- Beiträge

- 294

- Renomée

- 14

- Standort

- Siegen

- Mein Laptop

- HP 15 (AMD A6-7310, Full-HD IPS matt, 8GB DDR3-1600, 500GB SSHD)

- Details zu meinem Desktop

- Prozessor

- AMD FX-6300@4GHz (vorher Phenom II 965BE@3,8GHz, Athlon II X4 640@3,6GHz)

- Mainboard

- ASRock 970 Extreme4

- Kühlung

- GELID Tranquillo Rev. 2

- Speicher

- 8GB Corsair CMX8GX3M2A1600C9

- Grafikprozessor

- AMD Radeon R9 280X

- Display

- Samsung SyncMaster 2433BW

- Webbrowser

- Cyberfox AMD64

Hi naja nicht ganzda der 3200 Speicher nur mit 2933 lief aber gut zu sehen das Dual Rank auch übertatet werden kann, viele haben ja schon mit den XMP Frequenzen Probleme diese zum laufen zu bekommen.

Als ich den Link gepostet habe, hatte ich das Video noch nicht zu Ende geschaut, habe mich dann sehr gewundert, dass der Crucial DR 2933 OC so schlecht performt,

Golem hatte Dual Ranked DDR4-2667 CL16-16-16-36-1T ziemlich gleich auf mit Single Ranked DDR4-3200 CL14-14-14-34-1T getestet.

Vermutlich leidet Dual Rank stärker unter schlechten Timings als Single Rank Speicher (Rawiioli hat mit CL20 getestet), mit DR 2933 MHz sollte eigentlich noch ein Leistungsplus zu SR 3200 MHz drin sein.

Daher wurden die Samsung B site so gepusht weil die doch gemessen an den anderen die besten Ergebnisse hatten, wenn ich das nur bei mir anschaue die starten sogar mit 3600 CL16.

Jo, dachte ich auch, Pustekuchen, die G.Skill TridentZ F4-3600C17D-16GTZKW wollten bei mir auffem C6H nicht stabil über 3200 MHz @CL14-14-14-34 hinaus, reichte mir aber auch erstmal so, bis die neuen Teiler kommen...

Zuletzt bearbeitet:

Atombossler

Admiral Special

- Mitglied seit

- 28.04.2013

- Beiträge

- 1.425

- Renomée

- 65

- Standort

- Andere Sphären

- Mein Laptop

- Thinkpad 8

- Details zu meinem Desktop

- Prozessor

- A8-7600@3.25Ghz

- Mainboard

- Asus A88X-PRO

- Kühlung

- NoFan CR80 EH

- Speicher

- 16Gb G-Skill Trident-X DDR3 2400

- Grafikprozessor

- APU

- Display

- Acer UHD 4K2K

- SSD

- Samsung 850 PRO

- HDD

- 2xSamsung 1TB HDD (2,5")

- Optisches Laufwerk

- Plexi BD-RW

- Soundkarte

- OnBoard Geraffel

- Gehäuse

- Define R2

- Netzteil

- BeQuiet

- Betriebssystem

- Win7x64-PRO

- Webbrowser

- Chrome

Crucial Ballistix Sport BLS2C8G4D240FSE (121,57€ / 121,90€ / 129€ VSKF) läuft Dual Ranked @ 2933 MHz @ AM4 und entspricht damit der Leistung der teuren G.Skill 3200 MHz Single Rank Speicher! (Quelle Rawiioli @Youtube)

Na ja, der gute Rawiioli ...

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

Ein Hort verlässlicher Informationen ist er für mich nun aber nicht gerade, nachdem er es in diesem Video ->

Ich mein, klar taucht der RAM da doppelt auf, nämlich einmal unter RyZen und dann nochmal unter APU (also Bristol Ridge) und BR hat nun mal einen anderen Speicherkontroller als RyZen. Da kann der gleiche Speicher eben nur noch mit DDR4-2133 betrieben werden.

Deswegen den Board-Hersteller, oder den RAM-Hersteller zu dissen kommt mir etwas komisch vor.

Aber na ja, YouTuber eben ...

Das man generell Crucial RAM recht gut übertakten kann ist nun auch nichts Neues.

Auch der Preis ist jetzt nichts Sensationelles, gab den Trident-Z vor kurzem im Angebot zum selben Kurs, aber eben auf 3200 cl14 spezifiziert.

Überhaupt ... wie kann man denn Trident-Z RAM mit ungeraden Timings kaufen und für RyZen verwenden wollen?

Bzw. ist nur bei cl14 sicher, das es Samsung B-Dies sind, bei anderen Timings (höheren) eben nicht, können also genauso gut Hynix gewesen sein, welche dann natürlich

bekanntermassen nicht auf 3200 laufen.

Da soll er erstmal recherchieren, der gute ... bevor er mit seinem Halbwissen um sich wirft.

Marius87

Fleet Captain Special

- Mitglied seit

- 08.04.2015

- Beiträge

- 294

- Renomée

- 14

- Standort

- Siegen

- Mein Laptop

- HP 15 (AMD A6-7310, Full-HD IPS matt, 8GB DDR3-1600, 500GB SSHD)

- Details zu meinem Desktop

- Prozessor

- AMD FX-6300@4GHz (vorher Phenom II 965BE@3,8GHz, Athlon II X4 640@3,6GHz)

- Mainboard

- ASRock 970 Extreme4

- Kühlung

- GELID Tranquillo Rev. 2

- Speicher

- 8GB Corsair CMX8GX3M2A1600C9

- Grafikprozessor

- AMD Radeon R9 280X

- Display

- Samsung SyncMaster 2433BW

- Webbrowser

- Cyberfox AMD64

Hat hier gerade noch jemand die Kosten für eine Maske in 14nm/28nm/32nm im Kopf?

Ich meine mal eine schöne Gegenüberstellung bzgl. Ryzen hier oder anderswo gelesen zu haben, leider lässt ich dies spontan nicht mehr ergoogeln.

Ich meine mal eine schöne Gegenüberstellung bzgl. Ryzen hier oder anderswo gelesen zu haben, leider lässt ich dies spontan nicht mehr ergoogeln.

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 92

- Aufrufe

- 8K

- Antworten

- 14

- Aufrufe

- 935

- Antworten

- 102

- Aufrufe

- 11K

- Antworten

- 3

- Aufrufe

- 2K