App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

[Usertest] AMD Radeon Vega Frontier Edition - Bilder, Benchmarks, Energiemessungen

- Ersteller Yoshi 2k3

- Erstellt am

BoMbY

Grand Admiral Special

- Mitglied seit

- 22.11.2001

- Beiträge

- 7.468

- Renomée

- 293

- Standort

- Aachen

- Details zu meinem Desktop

- Prozessor

- Ryzen 3700X

- Mainboard

- Gigabyte X570 Aorus Elite

- Kühlung

- Noctua NH-U12A

- Speicher

- 2x16 GB, G.Skill F4-3200C14D-32GVK @ 3600 16-16-16-32-48-1T

- Grafikprozessor

- RX 5700 XTX

- Display

- Samsung CHG70, 32", 2560x1440@144Hz, FreeSync2

- SSD

- AORUS NVMe Gen4 SSD 2TB, Samsung 960 EVO 1TB, Samsung 840 EVO 1TB, Samsung 850 EVO 512GB

- Optisches Laufwerk

- Sony BD-5300S-0B (eSATA)

- Gehäuse

- Phanteks Evolv ATX

- Netzteil

- Enermax Platimax D.F. 750W

- Betriebssystem

- Windows 10

- Webbrowser

- Firefox

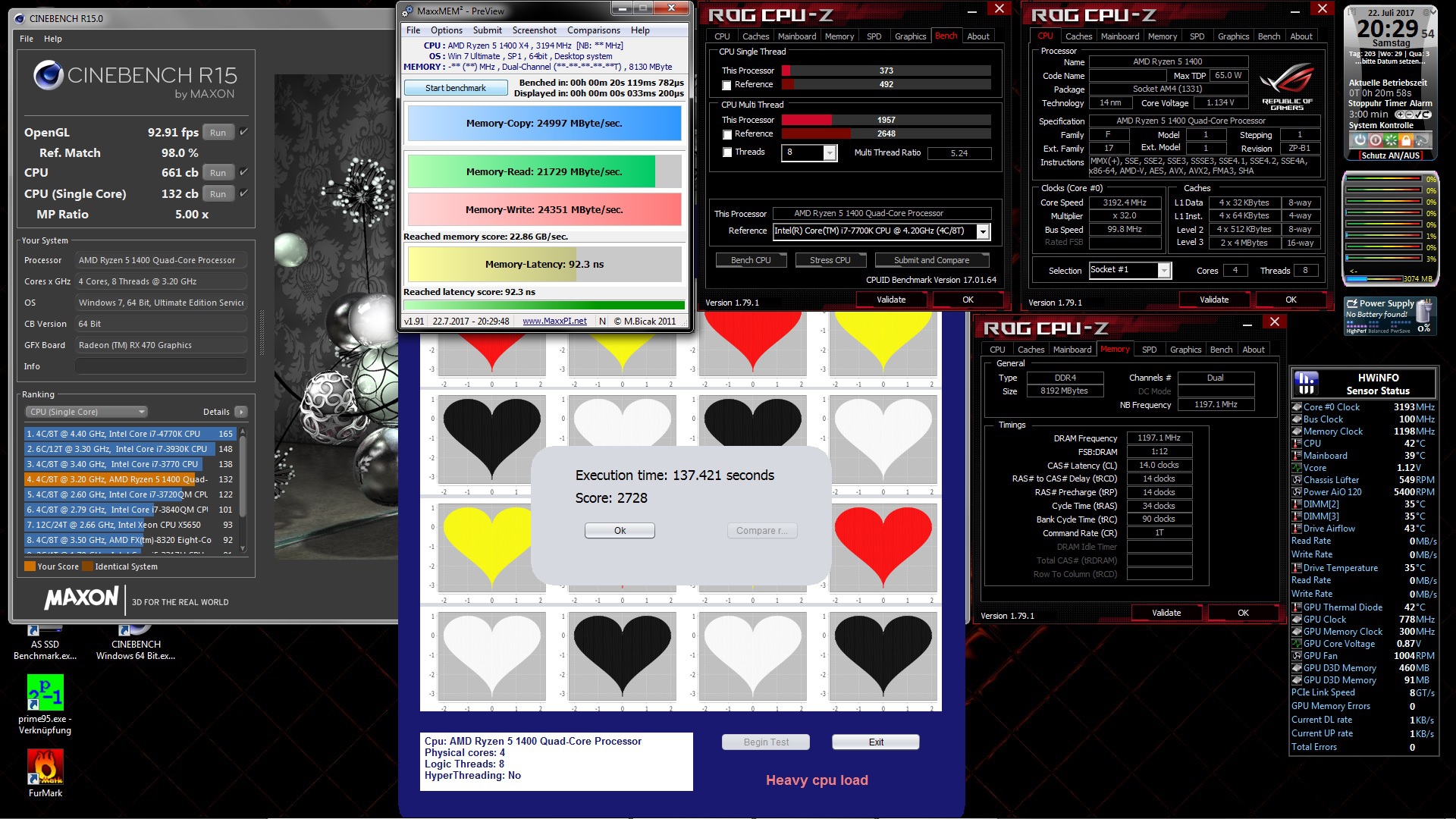

Vielen Dank. Die Werte finde ich sehr interessant im Vergleich zu einer GP102 (Werte aus CB Forum) zum Beispiel:

Edit:

Hier auch nochmal meine Fury X Werte zum Vergleich: (der Ryzen im Moment ohne SMT):

Der Memory-Copy erscheint mir sehr langsam bei der Vega FE.

Edit:

Hier auch nochmal meine Fury X Werte zum Vergleich: (der Ryzen im Moment ohne SMT):

Der Memory-Copy erscheint mir sehr langsam bei der Vega FE.

Zuletzt bearbeitet:

Yoshi 2k3

Admiral Special

- Mitglied seit

- 18.01.2003

- Beiträge

- 1.321

- Renomée

- 180

- BOINC-Statistiken

- Mein Laptop

- Apple Mac Book Pro 14" 2023

- Details zu meinem Desktop

- Prozessor

- AMD Epyc 7F52

- Mainboard

- TYAN S8030 GM2NE

- Kühlung

- Watercool Heatkiller IV

- Speicher

- 128 GB Samsung M393A4K40DB3-CWEGQ

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- Nixeus NX-EDG27

- Soundkarte

- SMSL SU-9 USB DAC

- Gehäuse

- Caselabs SM8

- Netzteil

- Cooler Master SFX Gold 850W

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Schau Dir das System auf sysprofile.de an

Super Vergleichswerte, danke. Ich behaupte, das liegt an AIDA64. Der kann mit der Vega FE bisher absolut nichts anfangen. Keine Temp-Sensoren, kein Energieverbauch, keine Lüfterdrehzahl, nichts wird angezeigt. Unter "Sensoren" taucht nix auf, was mit der GPU zu tun hat. Von daher gehe ich davon aus, dass neuere versionen in Zukunft andere Ergebnisse liefern werden.

Meine Karte läuft momentan unter Volllast und der Crimson wirkt mal wieder sehr fehlerbehaftet. Ich kann im WattMan momentan keine Core Frequenzn oder Core Voltages anpassen. Nur der höchste/letzte P-State lässt sich ändern, alle anderen sind N/A. Das lässt sich erst beheben, wenn ich den Rechner komplett herunterfahre. Ein einfacher Neustart reicht nicht. Oder, was schlimmer wäre, es liegt nicht am Crimson sondern am BIOS der Karte selbst.

Kann ich das bei AMD eigentlich direkt melden?

€dit: PC Perspective macht aber gleich Nägel mit Köpfen

Meine Karte läuft momentan unter Volllast und der Crimson wirkt mal wieder sehr fehlerbehaftet. Ich kann im WattMan momentan keine Core Frequenzn oder Core Voltages anpassen. Nur der höchste/letzte P-State lässt sich ändern, alle anderen sind N/A. Das lässt sich erst beheben, wenn ich den Rechner komplett herunterfahre. Ein einfacher Neustart reicht nicht. Oder, was schlimmer wäre, es liegt nicht am Crimson sondern am BIOS der Karte selbst.

Kann ich das bei AMD eigentlich direkt melden?

€dit: PC Perspective macht aber gleich Nägel mit Köpfen

Zuletzt bearbeitet:

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Zuletzt bearbeitet:

Darkearth21

Fleet Captain Special

- Mitglied seit

- 30.01.2003

- Beiträge

- 289

- Renomée

- 23

- Standort

- Hannover

- Details zu meinem Desktop

- Prozessor

- Ryzen 3800X @ Auto OC + Ryzen 3900X @ Stock

- Mainboard

- Asus Crosshair 6 Hero + MSI Unify X570

- Kühlung

- Alphacool Eisbaer Modded + Wraith Prism

- Speicher

- 2 x 16GB E-Dies @ 3733CL16 + 2 x 16GB E-Dies @3733CL16

- Grafikprozessor

- MSI GTX 1080Ti Gaming X 11G @ 1760 / 5900 MHz @ 0.879v + Radeon RX570 @ Stock

- Display

- BenQ 3203R + BenQ XL2730Z 27" 144Hz

- SSD

- Samsung Evo 840 256GB, Crucial MX200 500GB Crucial MX 500 1TB + Samsung Evo 850 256GB

- HDD

- 1x Extern 1TB WD Green im Hardcase + 1x 2TB Toschiba

- Optisches Laufwerk

- keines mehr

- Gehäuse

- NZXT s340 Elite White + Nokia 3310 Oldschool Tower

- Netzteil

- Corsair RM850X Weiß + bQuiet! DPP 550w

- Betriebssystem

- Win10 64 ProN + Win 64 Pro

- Webbrowser

- Firefox | Nightly

Vielen Dank. Die Werte finde ich sehr interessant im Vergleich zu einer GP102......

Ich hab hier auch noch mal einen Vergleichswert von Aida64 mit einer 1080Ti / bzw. 2 Vergleichswerte.

Mir ist nämlich aufgefallen, dass bei GPGPU die Ti nicht in den P0 State wechselt, sondern im P1 State verweilt.

(P0 = 2100 / 6000 MHz | P1 = 1550 / 5500 MHz)

Die Werte die Aida selbst hinterlegt hat sind nicht im Ansatz korrekt, denke es liegt am Boost 3.0

Lege ich zusätzliche Last an, sind die Werte bei den SP und DP Berechnungen sehr nah an der XP, allerdings ist die Speichergeschwindigkeit dann weitaus geringer (was ja verständlich ist, wenn er im Hintergrund noch etwas berechnen muss)

Bild 1 mit P1 State :

Bild 2 mit P0 State:

Ok, außerdem ist bei mir der Unterbau nur ein 4 Kerner, aber daran sollte es bei diesem Test ja nicht liegen.

Zuletzt bearbeitet:

Casi030

Grand Admiral Special

- Mitglied seit

- 03.10.2012

- Beiträge

- 8.942

- Renomée

- 153

Das ist aber mager bei dir.

Der Fx @ 4,5GHz?!

2 Core / 4Threads machen dann bei Dir nur magere rund 1500

und das mit 4,5GHz..........

und das mit 4,5GHz..........Bremst dein FX künstlich aus?!

http://abload.de/image.php?img=beatbench1.1rkuvg.jpg

Yoshi 2k3

Admiral Special

- Mitglied seit

- 18.01.2003

- Beiträge

- 1.321

- Renomée

- 180

- BOINC-Statistiken

- Mein Laptop

- Apple Mac Book Pro 14" 2023

- Details zu meinem Desktop

- Prozessor

- AMD Epyc 7F52

- Mainboard

- TYAN S8030 GM2NE

- Kühlung

- Watercool Heatkiller IV

- Speicher

- 128 GB Samsung M393A4K40DB3-CWEGQ

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- Nixeus NX-EDG27

- Soundkarte

- SMSL SU-9 USB DAC

- Gehäuse

- Caselabs SM8

- Netzteil

- Cooler Master SFX Gold 850W

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Schau Dir das System auf sysprofile.de an

Im Time Spy macht mein System nun mit ein wenig Undervolting 7197 Punkte. Das sind ~200 mehr als @Stock.

http://www.3dmark.com/3dm/20861645

http://www.3dmark.com/3dm/20861645

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

@Casi030

Hast du das schon mal gemacht?

Der TimeSpy lauf sieht gut aus.

Bei AIDA64 gibt es die Möglichkeit einen Bericht zu erstellen und ihn zum AIDA64 Server hoch zu laden.Super Vergleichswerte, danke. Ich behaupte, das liegt an AIDA64. Der kann mit der Vega FE bisher absolut nichts anfangen. Keine Temp-Sensoren, kein Energieverbauch, keine Lüfterdrehzahl, nichts wird angezeigt. Unter "Sensoren" taucht nix auf, was mit der GPU zu tun hat. Von daher gehe ich davon aus, dass neuere versionen in Zukunft andere Ergebnisse liefern werden.

Hast du das schon mal gemacht?

Der TimeSpy lauf sieht gut aus.

Yoshi 2k3

Admiral Special

- Mitglied seit

- 18.01.2003

- Beiträge

- 1.321

- Renomée

- 180

- BOINC-Statistiken

- Mein Laptop

- Apple Mac Book Pro 14" 2023

- Details zu meinem Desktop

- Prozessor

- AMD Epyc 7F52

- Mainboard

- TYAN S8030 GM2NE

- Kühlung

- Watercool Heatkiller IV

- Speicher

- 128 GB Samsung M393A4K40DB3-CWEGQ

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- Nixeus NX-EDG27

- Soundkarte

- SMSL SU-9 USB DAC

- Gehäuse

- Caselabs SM8

- Netzteil

- Cooler Master SFX Gold 850W

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Schau Dir das System auf sysprofile.de an

"Arbeite" momentan mit Martin Malik, dem Entwickler von HWiNFO, an passender Unterstützung. Um AIDA64 hab ich mich noch nicht weiter gekümmert. Ich habe vorhin mal testweise den RAM-Takt auf 1100 MHz hochgezogen (bei +25mV Spannung) und AIDA64 schafft dann ~343.000 MB/s, Höchstwert waren heute ~349.000 MB/s bei Memory Copy. Ich könnte mir vorstellen, dass da tatsächlich ECC in die Parade fährt. Zeigt aber auch, wie eine RX Vega evtl aussehen könnte. Meine Glaskugel sagt, dass am Core-Takt nicht mehr viel geändert wird, dafür der Speichertakt noch ein gutes Stück nach oben geht. Ich mutmaße, dass das RX Vega Ref Design von AMD 1600 MHz Core-Takt und 1050 MHz RAM-Takt haben wird. Ob die Boardpartner daran etwas ändern wird man sehen, ich könnte mir vorstellen, dass die die angesetzte Spannung etwas nach unten korrigieren werden.

Ich bin wirklich gespannt ob ich Recht behalte mit der Einschätzung.

Ich bin wirklich gespannt ob ich Recht behalte mit der Einschätzung.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

@Yoshi 2k3

Gut zu wissen bezüglich Mr. Malik

Mein GPGPU Wert mit standard Takt bei der GPU (925/1375MHz) : http://abload.de/img/aida64_580_gpgpubenchjnqle.jpg

Gut zu wissen bezüglich Mr. Malik

Mein GPGPU Wert mit standard Takt bei der GPU (925/1375MHz) : http://abload.de/img/aida64_580_gpgpubenchjnqle.jpg

Casi030

Grand Admiral Special

- Mitglied seit

- 03.10.2012

- Beiträge

- 8.942

- Renomée

- 153

Ich würde es ja wie immer "im Bios 2 Module abschalten und" selber Testen,ABER hab den FX ja vor ner Weile Verkauft.@Casi030

Yoshi 2k3

Admiral Special

- Mitglied seit

- 18.01.2003

- Beiträge

- 1.321

- Renomée

- 180

- BOINC-Statistiken

- Mein Laptop

- Apple Mac Book Pro 14" 2023

- Details zu meinem Desktop

- Prozessor

- AMD Epyc 7F52

- Mainboard

- TYAN S8030 GM2NE

- Kühlung

- Watercool Heatkiller IV

- Speicher

- 128 GB Samsung M393A4K40DB3-CWEGQ

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- Nixeus NX-EDG27

- Soundkarte

- SMSL SU-9 USB DAC

- Gehäuse

- Caselabs SM8

- Netzteil

- Cooler Master SFX Gold 850W

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Schau Dir das System auf sysprofile.de an

Hab noch ein paar Mining-Ergebnisse hinzugefügt und BOINC ist in Planung. Collatz ist schon drin, für Einstein rechnet gerade ein bisschen was. Habt ihr andere spannende GPU-Projekte, die man im BOINC noch testen könnte?

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Ich schalte via Energiesparplan ab, dann spar ich mir das übertakten.Ich würde es ja wie immer "im Bios 2 Module abschalten und" selber Testen,ABER hab den FX ja vor ner Weile Verkauft.

Die 4.5GHz sind mit allen UEFI Energieoptionen und knapp über 155W Delta (mit CoreParking!)

Collatz ist sehr AMD Software favorisiert, Einstein geht auch auf nvidia.Hab noch ein paar Mining-Ergebnisse hinzugefügt und BOINC ist in Planung. Collatz ist schon drin, für Einstein rechnet gerade ein bisschen was. Habt ihr andere spannende GPU-Projekte, die man im BOINC noch testen könnte?

Aber die Herausfoderung ist das Projekt "MilkyWay"...

Yoshi 2k3

Admiral Special

- Mitglied seit

- 18.01.2003

- Beiträge

- 1.321

- Renomée

- 180

- BOINC-Statistiken

- Mein Laptop

- Apple Mac Book Pro 14" 2023

- Details zu meinem Desktop

- Prozessor

- AMD Epyc 7F52

- Mainboard

- TYAN S8030 GM2NE

- Kühlung

- Watercool Heatkiller IV

- Speicher

- 128 GB Samsung M393A4K40DB3-CWEGQ

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- Nixeus NX-EDG27

- Soundkarte

- SMSL SU-9 USB DAC

- Gehäuse

- Caselabs SM8

- Netzteil

- Cooler Master SFX Gold 850W

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Schau Dir das System auf sysprofile.de an

Na dann werfen wir doch mal Milky an. Da hab ich sogar noch einen Account  Einstein-Ergebnisse sind im Startpost.

Einstein-Ergebnisse sind im Startpost.

Einstein-Ergebnisse sind im Startpost.

Einstein-Ergebnisse sind im Startpost.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

THX!Na dann werfen wir doch mal Milky an. Da hab ich sogar noch einen AccountEinstein-Ergebnisse sind im Startpost.

Ich schau mal drüber, sobald ein Zeit-Fenster vorhanden ist.

Mit +20% Power Limit im Crimson, sind es 2x 270W TDP (Board Design)

Yoshi 2k3

Admiral Special

- Mitglied seit

- 18.01.2003

- Beiträge

- 1.321

- Renomée

- 180

- BOINC-Statistiken

- Mein Laptop

- Apple Mac Book Pro 14" 2023

- Details zu meinem Desktop

- Prozessor

- AMD Epyc 7F52

- Mainboard

- TYAN S8030 GM2NE

- Kühlung

- Watercool Heatkiller IV

- Speicher

- 128 GB Samsung M393A4K40DB3-CWEGQ

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- Nixeus NX-EDG27

- Soundkarte

- SMSL SU-9 USB DAC

- Gehäuse

- Caselabs SM8

- Netzteil

- Cooler Master SFX Gold 850W

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Schau Dir das System auf sysprofile.de an

So, Milky wäre auch drin. 54 Sekunden laufzeit pro WU scheint mir jetzt aber nicht besonders aufwendig. Oder ich hab noch keine Kracher-WU bekommen

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Not bad, aber laufen dann auch 2 WorkingUnits bei deiner Vega?So, Milky wäre auch drin. 54 Sekunden laufzeit pro WU scheint mir jetzt aber nicht besonders aufwendig. Oder ich hab noch keine Kracher-WU bekommen

http://abload.de/img/milkywayhome_stock53u0i.jpg

Der Lastwechsel hat es in sich!

Zuletzt bearbeitet:

Casi030

Grand Admiral Special

- Mitglied seit

- 03.10.2012

- Beiträge

- 8.942

- Renomée

- 153

Naja,dann komm Ich dir mal entgegen.

Delta um 50W

Bin auch mal mit dem Takt ein wenig rauf gekommen.

Delta um 120W

Ich würde es ja wie immer "im Bios 2 Module abschalten und" selber Testen,ABER hab den FX ja vor ner Weile Verkauft.

Ich schalte via Energiesparplan ab, dann spar ich mir das übertakten.

Die 4.5GHz sind mit allen UEFI Energieoptionen und knapp über 155W Delta (mit CoreParking!)

Delta um 50W

Bin auch mal mit dem Takt ein wenig rauf gekommen.

Delta um 120W

Zuletzt bearbeitet:

Hm, beim ZCash-Mining nur ~350 Sol/s  Damit läge die Vega FE zwischen einer GeForce GTX 1060 und 1070; bei deutlich höherem Stromverbrauch.

Damit läge die Vega FE zwischen einer GeForce GTX 1060 und 1070; bei deutlich höherem Stromverbrauch.

Auch 900 H/s bei Monero sind nicht so dolle. Ein AMD Ryzen 7 1700 schafft mit dem CPU-Miner @Stock 500 H/s bei nur ~90 W Volllastverbrauch (Gesamtsystem). Da dürfte die Vega nur 160 W verbrauchen, um wenigstens auf die gleiche Effizienz zu kommen wie Ryzen. Das wird sie wohl "knapp" nicht schaffen.

nicht schaffen.

Damit läge die Vega FE zwischen einer GeForce GTX 1060 und 1070; bei deutlich höherem Stromverbrauch.

Damit läge die Vega FE zwischen einer GeForce GTX 1060 und 1070; bei deutlich höherem Stromverbrauch.

Auch 900 H/s bei Monero sind nicht so dolle. Ein AMD Ryzen 7 1700 schafft mit dem CPU-Miner @Stock 500 H/s bei nur ~90 W Volllastverbrauch (Gesamtsystem). Da dürfte die Vega nur 160 W verbrauchen, um wenigstens auf die gleiche Effizienz zu kommen wie Ryzen. Das wird sie wohl "knapp"

nicht schaffen.

nicht schaffen.

Zuletzt bearbeitet:

Yoshi 2k3

Admiral Special

- Mitglied seit

- 18.01.2003

- Beiträge

- 1.321

- Renomée

- 180

- BOINC-Statistiken

- Mein Laptop

- Apple Mac Book Pro 14" 2023

- Details zu meinem Desktop

- Prozessor

- AMD Epyc 7F52

- Mainboard

- TYAN S8030 GM2NE

- Kühlung

- Watercool Heatkiller IV

- Speicher

- 128 GB Samsung M393A4K40DB3-CWEGQ

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- Nixeus NX-EDG27

- Soundkarte

- SMSL SU-9 USB DAC

- Gehäuse

- Caselabs SM8

- Netzteil

- Cooler Master SFX Gold 850W

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Schau Dir das System auf sysprofile.de an

Ich glaube aber, dass das eher an nicht optimierten Minern liegt. Manche, wie der Claymore, funktionieren mit der Vega FE gar nicht. Da ist also nch etwas Arbeit nötig, bevor es zu 100% verlässliche Ergebnisse geben wird...

Ja, das kann natürlich auch sein. GPGPU-Computing, was Mining ja beinahe in reinster Form ist, müsste der Vega doch eigentlich auf den Leib geschneidert sein. Wenn hier nichts vorwärts geht, wo dann?  Mal ein paar aktualisierte Miner-Versionen abwarten.

Mal ein paar aktualisierte Miner-Versionen abwarten.

Läuft der Nicehash Miner nicht mit Vega?

Mal ein paar aktualisierte Miner-Versionen abwarten.

Mal ein paar aktualisierte Miner-Versionen abwarten.Läuft der Nicehash Miner nicht mit Vega?

Zuletzt bearbeitet:

G

Gast29012019_2

Guest

Ist doch gut so, wer den Schrott noch optimiert kann mal 1000 Euro für eine 1080TI hinblättern, ich denke das will hier niemand. Und ich hoffe auch das Nvidia mit Volta Mining im negativen Sinne beeinträchtigen wird, sonst kommt die nächste Welle wo die Grafikkarten wieder mit Gold aufgelegt werden.

Gozu

Vice Admiral Special

- Mitglied seit

- 19.02.2017

- Beiträge

- 521

- Renomée

- 70

- Mein Laptop

- Asus ROG Zephyrus G14 2022 (GA402RJ-L8116W) / HP 15s-eq1158ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 5900

- Mainboard

- AsRock B550 Phantom Gaming Velocita

- Kühlung

- Coolermaster MASTERLIQUID 120

- Speicher

- 2x 16GB HyperX KHX3733C19D4/16GX 3733-19

- Grafikprozessor

- AsRock RX 6800 Phantom Gaming D 16G

- Display

- 27 " iiyama G-Master GB2760QSU WQHD

- HDD

- 2x WDC WD10EADS-11P8B1

- Optisches Laufwerk

- TSSTcorp CDDVDW SH-2

- Gehäuse

- CoolerMaster HAF XB

- Netzteil

- Enermax EDT1250EWT

- Maus

- Rocat Kova

- Betriebssystem

- Windows 10 Professional x64, Manjaro

- Webbrowser

- Iron

- Internetanbindung

- ▼1000 MBit ▲50 MBit

Nicehash nutzt auch nur andere Mining Programme wie SG Miner, oder die von Claymore. Claymore hat bei Bitcointalk geschrieben daß er sich erst darum kümmern wird wenn die RX Vega auf dem Markt ist. Die Miner von Claymore haben so eine hohe Hashrate, weil sie für jede Hardware einen angepassten Kernel haben.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

OffT

OnT

Evt. wird AMD auch Versuchen zu verhindern, dass die Miner am Anfang alles "abgrasen" aufgrund der geringen Stückzahl am Anfang.

Erste Reaktionen sind ja seitens der Hersteller schon geschehen, es werden nun extra Mining GPUs angeboten ohne Monitor Ausgänge.

Oha, Gänsehaut feeling wa?Naja,dann komm Ich dir mal entgegen.

Delta um 50W

Bin auch mal mit dem Takt ein wenig rauf gekommen.

Delta um 120W

Evt. wird AMD auch Versuchen zu verhindern, dass die Miner am Anfang alles "abgrasen" aufgrund der geringen Stückzahl am Anfang.

Erste Reaktionen sind ja seitens der Hersteller schon geschehen, es werden nun extra Mining GPUs angeboten ohne Monitor Ausgänge.

Ja, hoffentlich spricht das die professionellen Miner in China an. Die, die das als Zubrot nebenher machen, haben ja ein anderes Geschäftsmodell. Die kaufen eine brandaktuelle Grafikkarte, lassen sie ein halbes Jahr minen und verkaufen dann die immer noch relativ aktuelle Grafikkarte als gebraucht in der Bucht. Damit kostet sie die Grafikkarte nicht den vollen Kaufpreis, sondern ehemaliger Kaufpreis minus gebrauchten Wiederverkaufspreis. Bei einer Grafikkarte ohne Monitorausgänge jedoch funktioniert das nicht, denn welcher private Schnäppchenjäger in der Bucht kauft schon eine Grafikkarte ohne MonitorausgängeErste Reaktionen sind ja seitens der Hersteller schon geschehen, es werden nun extra Mining GPUs angeboten ohne Monitor Ausgänge.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

@Nero24.

Naja, ohne Montior Ausgang bedeute auch 0W wenn sie nicht minnt, oder ist das Feature noch deaktiviert?

Naja, ohne Montior Ausgang bedeute auch 0W wenn sie nicht minnt, oder ist das Feature noch deaktiviert?

Ähnliche Themen

- Antworten

- 14

- Aufrufe

- 8K

- Antworten

- 8

- Aufrufe

- 3K

- Antworten

- 0

- Aufrufe

- 772

- Antworten

- 1

- Aufrufe

- 1K