APU13: APUs f├╝r die Datenwolke, Videocodierung, JAVA, C++ AMP f├╝r Linux und mehr

Beispielszenarien

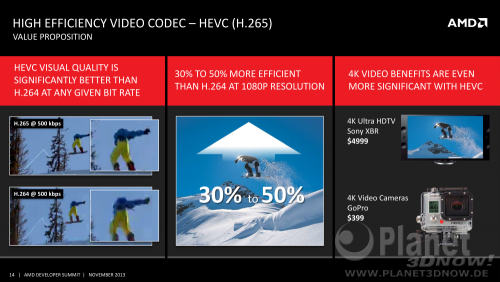

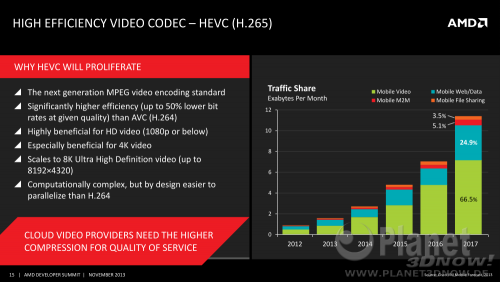

Als┬Łdann wur┬Łden kon┬Łkre┬Łte Anwen┬Łdungs┬Łbei┬Łspie┬Łle f├╝r APUs in der Daten┬Łwol┬Łke genannt. Ers┬Łtes Bei┬Łspiel war der neue Video┬Łco┬Łdec HVEC (H.265), dem Nach┬Łfol┬Łger des bekann┬Łten H.264-Codecs:

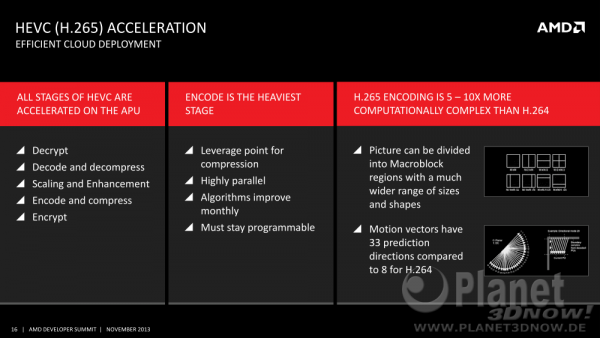

Abge┬Łse┬Łhen von der deut┬Łlich bes┬Łse┬Łren Bild┬Łqua┬Łli┬Łt├żt gegen┬Ł├╝ber dem Vor┬Łg├żn┬Łger sieht AMD vor allem einen Vor┬Łteil: Der Codec ist von Haus aus leich┬Łter par┬Łal┬Łle┬Łli┬Łsier┬Łbar, da er das Bild in Seg┬Łmen┬Łte unterteilt:

Dadurch f├żllt dann auch der 10x gr├Č┬Ł├¤e┬Łre Rechen┬Łauf┬Łwand weni┬Łger ins Gewicht, not┬Łfalls m├╝s┬Łsen die Daten┬Łwol┬Łken┬Łzen┬Łtren nur mehr APUs bei AMD bestel┬Łlen. Dies wer┬Łden sie sicher┬Łlich tun, denn die ein┬Łge┬Łspar┬Łte Band┬Łbrei┬Łte auf┬Łgrund der deut┬Łlich bes┬Łse┬Łren Video┬Łkom┬Łpri┬Łmie┬Łrung von H.265 ist es ihnen sicher┬Łlich wert:

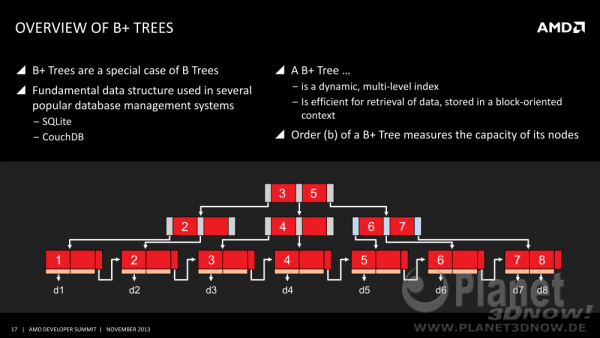

Als n├żchs┬Łtes Bei┬Łspiel wur┬Łden B+-B├żume gezeigt. Die┬Łse Daten┬Łstruk┬Łtu┬Łren wer┬Łden bei eini┬Łgen Daten┬Łban┬Łken ein┬Łge┬Łsetzt, erw├żhnt wur┬Łden CouchDB sowie SQLi┬Łte . Eine nor┬Łma┬Łle Baum┬Łstruk┬Łtur ver┬Łl├żuft nur ver┬Łti┬Łkal, so wie ein Baum vom Erd┬Łbo┬Łden nach oben w├żchst. Daten in einem B+-Datenbau sind nun aber in der letz┬Łten Ebe┬Łne (der soge┬Łnann┬Łten Blatt┬Łebe┬Łne) auch direkt in einer Ebe┬Łne ver┬Łlinkt, was man an den hori┬Łzon┬Łta┬Łlen Pfei┬Łlen auf der n├żchs┬Łten Folie sehen kann:

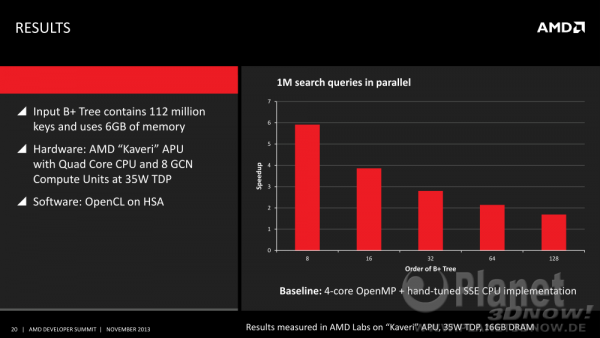

Der Geschwin┬Łdig┬Łkeits┬Łzu┬Łwachs durch den Ein┬Łsatz einer HSA-APU ŌĆō im Test┬Łfall ein Kaveri ŌĆō liegt zwi┬Łschen dem 1,9 und dem 6ŌĆæfachen des nor┬Łma┬Łlen Quad┬Łcore Kave┬Łris ohne GPU-Unterst├╝tzung:

Neben der gestie┬Łge┬Łnen Par┬Łal┬Łle┬Łli┬Łt├żt gibt ver┬Łweist AMD auch auf das Weg┬Łfal┬Łlen des Daten┬Łko┬Łpie┬Łrens zwi┬Łschen CPU und GPU, was bei einer gro┬Ł├¤en Daten┬Łbank nat├╝r┬Łlich gro├¤ ins Gewicht f├żllt:

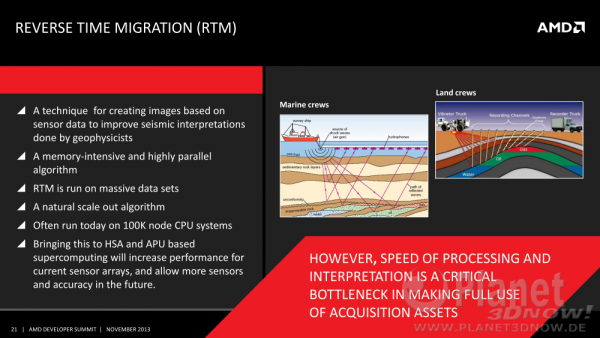

N├żchs┬Łtes Bei┬Łspiel war die Erd┬Ł├Čl┬Łf├Čr┬Łde┬Łrung. Dort fal┬Łlen rie┬Łsi┬Łge Daten┬Łmen┬Łgen bei der seis┬Łmi┬Łschen Unter┬Łsu┬Łchung der Erd┬Łkrus┬Łte an. Aktu┬Łell wer┬Łden die Daten┬Łmen┬Łgen in Rechen┬Łclus┬Łtern mit Hun┬Łde┬Łtau┬Łsen┬Łden CPUs berech┬Łnet, aber APUs k├Čnn┬Łten den sehr gut par┬Łal┬Łle┬Łli┬Łsier┬Łba┬Łren Daten┬Łwust nat├╝r┬Łlich noch bes┬Łser verarbeiten:

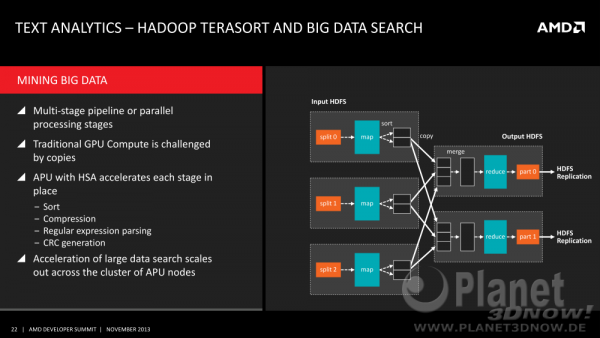

Ein Mix aus den letz┬Łten bei┬Łden Bei┬Łspie┬Łlen ist das n├żchs┬Łte: Text┬Łana┬Łly┬Łse mit┬Łtels Hadoop und Big-Data. Auch hier ist die Aus┬Łgangs┬Łla┬Łge eine gute Par┬Łal┬Łle┬Łli┬Łsier┬Łbar┬Łkeit und durch die schie┬Łre Daten┬Łmen┬Łge waren die Daten┬Łko┬Łpien im bis┬Łlang getrenn┬Łten CPU-GPU-Daten┬Łbe┬Łreich ein gro┬Ł├¤es Hin┬Łder┬Łnis. Mit hUMA hat man dage┬Łgen nat├╝r┬Łlich kein Pro┬Łblem mehr:

Zusam┬Łmen┬Łfas┬Łsend kann man sagen, dass sich AMD zur rich┬Łti┬Łgen HSA-Zeit am rich┬Łti┬Łgen Wol┬Łken-Ort w├żhnt:

Sicher┬Łlich wird es auch Anwen┬Łdungs┬Łbe┬Łrei┬Łche geben, die nicht so gut auf APUs lau┬Łfen wer┬Łden, jedoch schei┬Łnen die┬Łse nicht stark ins Gewicht zufal┬Łlen, AMDs Stra┬Łte┬Łgie k├Čnn┬Łte also durch┬Łaus aufgehen.