AMD Zen 3 Architektur im Detail

√Ąnderungen ‚Äď Front-End und Load/Store

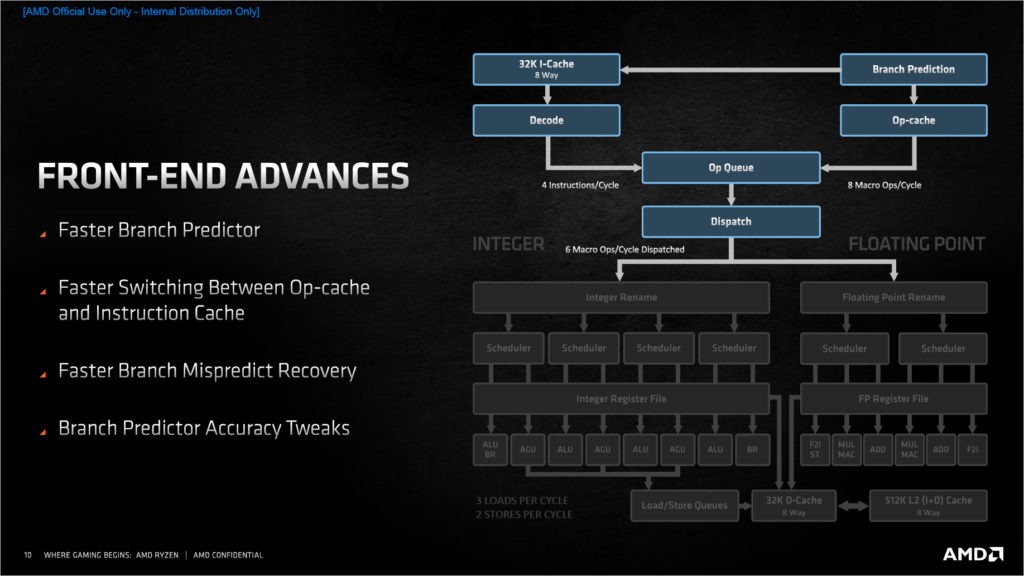

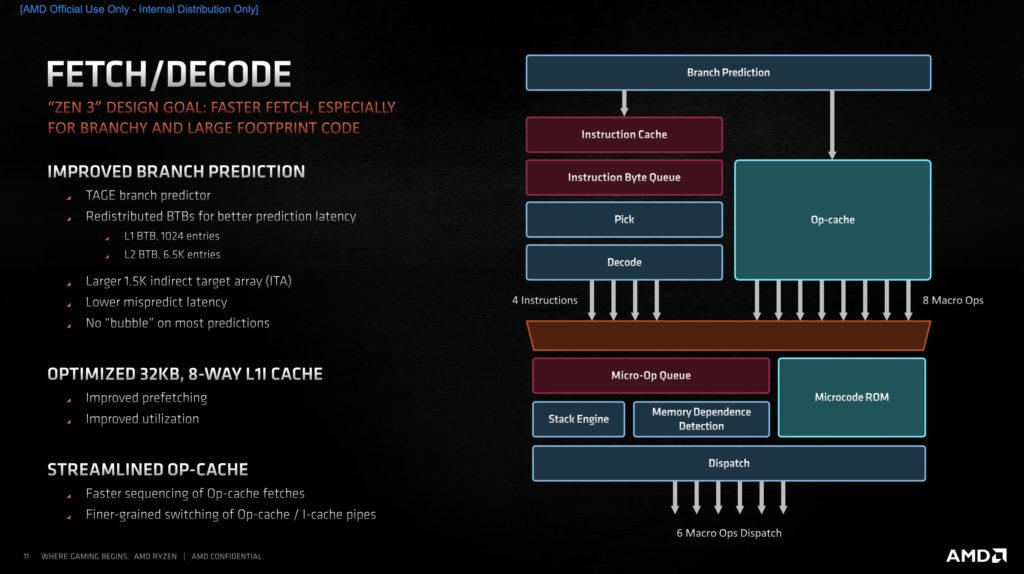

Nicht nur bei der Kom¬≠mu¬≠ni¬≠ka¬≠ti¬≠on zwi¬≠schen ein¬≠zel¬≠nen Ker¬≠nen, auch bei der Ver¬≠ar¬≠bei¬≠tung inner¬≠halb eines Kerns hat AMD ver¬≠sucht, Laten¬≠zen abzu¬≠fei¬≠len und Tot¬≠zeit zu redu¬≠zie¬≠ren. So pro¬≠kla¬≠miert AMD einen schnel¬≠le¬≠ren Branch Pre¬≠dic¬≠tor, ein schnel¬≠le¬≠res Umschal¬≠ten zwi¬≠schen Op-cache und Ins¬≠truc¬≠tion Cache, eine h√∂he¬≠re Tref¬≠fer¬≠quo¬≠te des Branch Pre¬≠dic¬≠tors und eine k√ľr¬≠ze¬≠re Reco¬≠very Zeit falls der Pre¬≠dic¬≠tor falsch gele¬≠gen hat. Ins¬≠ge¬≠samt war das Design¬≠ziel laut AMD, die Fetch¬≠pha¬≠se zu ver¬≠k√ľr¬≠zen, ins¬≠be¬≠son¬≠de¬≠re bei Code, der vie¬≠le Spr√ľn¬≠ge ent¬≠h√§lt und auf¬≠grund der Gr√∂¬≠√üe auf Pre¬≠fetch ange¬≠wie¬≠sen ist.

Wie schon bei Zen 2 setzt AMD auf einen TAGE Branch Pre¬≠dic¬≠tor. Aller¬≠dings arbei¬≠tet die¬≠ser laut AMD nun bei den meis¬≠ten Vor¬≠her¬≠sa¬≠gen mit ‚ÄúZero Bubble‚ÄĚ, also ohne Ver¬≠z√∂¬≠ge¬≠rung beim Aus¬≠le¬≠sen des Branch Tar¬≠get Buf¬≠fers (BTB), an wel¬≠cher Adres¬≠se denn nun der n√§chs¬≠te Befehl zu fin¬≠den ist. √úber¬≠haupt hat AMD am BTB ordent¬≠lich Hand ange¬≠legt. der L1BTB ist mit 1024 Ein¬≠tr√§¬≠gen glatt dop¬≠pelt so gro√ü wie bei Zen 2 und vier Mal so gro√ü wie bei Zen 1. Daf√ľr muss¬≠te der L2TLB mit 6500 vs. 7000 Ein¬≠tr√§¬≠gen etwas Federn lassen.

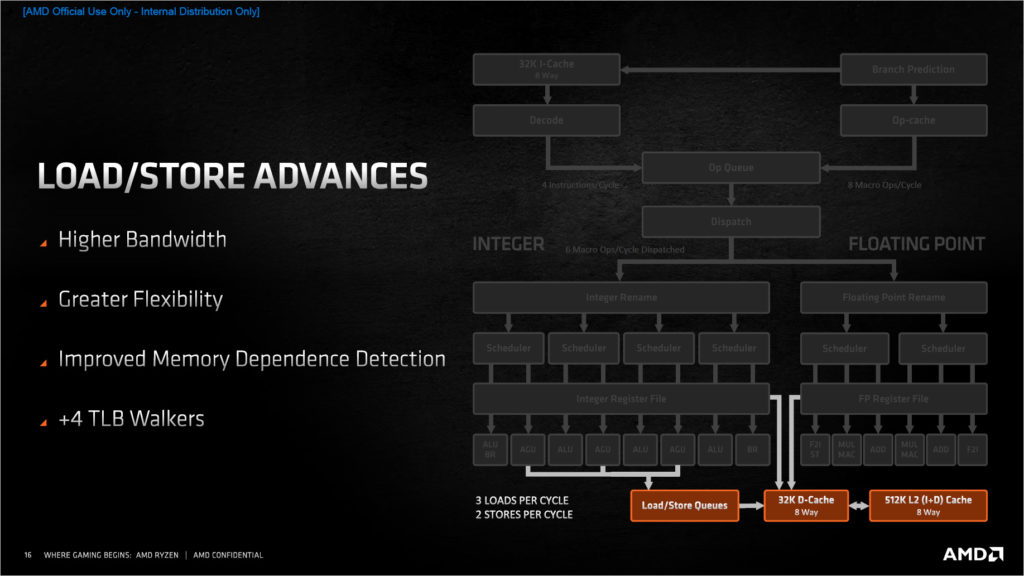

Beim Lesen und Schrei¬≠ben von Daten (Load/Store) hat AMD eben¬≠falls opti¬≠miert. Die Store Queue hat nun 64 Ein¬≠tr√§¬≠ge gegen¬≠√ľber 48 zuvor. Ins¬≠ge¬≠samt sol¬≠len gr√∂¬≠√üe¬≠re Struk¬≠tu¬≠ren vor¬≠ge¬≠la¬≠den wer¬≠den k√∂n¬≠nen, um Abh√§n¬≠gig¬≠kei¬≠ten bes¬≠ser auf¬≠l√∂¬≠sen zu k√∂n¬≠nen und mehr Ins¬≠truc¬≠tion Level Par¬≠al¬≠le¬≠lism (ILP) zu errei¬≠chen, um die Aus¬≠f√ľh¬≠rungs¬≠ein¬≠hei¬≠ten bes¬≠ser aus¬≠las¬≠ten zu k√∂n¬≠nen. Dazu wur¬≠de die Trans¬≠fer¬≠ra¬≠te der Loa¬≠d/S¬≠to¬≠re-Ein¬≠hei¬≠ten ver¬≠gr√∂¬≠√üert und fle¬≠xi¬≠bler gestaltet.