AMD Zen 2 und Rome ‚Äď was wir bisher wissen

Die kom¬≠men¬≠de CPU-Archi¬≠tek¬≠tur Zen 2 wird AMD zuerst im f√ľr 2019 geplan¬≠ten Ser¬≠ver-Pro¬≠zes¬≠sor Epyc ‚ÄúRome‚ÄĚ ein¬≠f√ľh¬≠ren. Das macht Sinn, da die Ser¬≠ver-Platt¬≠form den Zwi¬≠schen¬≠schritt ‚ÄúZen+‚ÄĚ √ľber¬≠sprun¬≠gen hat, der uns 2018 die in vie¬≠len Details ver¬≠bes¬≠ser¬≠ten Ryzen 2000 CPUs beschert hat. K√ľrz¬≠lich hat¬≠te AMD ja, wie berich¬≠tet, offi¬≠zi¬≠el¬≠le Infor¬≠ma¬≠tio¬≠nen zu Rome ver¬≠√∂f¬≠fent¬≠licht, aller¬≠dings auch vie¬≠le Details aus¬≠ge¬≠spart. In der Zwi¬≠schen¬≠zeit sind in der Ger√ľch¬≠te¬≠k√ľ¬≠che jedoch eini¬≠ge Info¬≠schnip¬≠sel dazu¬≠ge¬≠kom¬≠men, die wir nicht uner¬≠w√§hnt las¬≠sen wollen.

Zen 2 und Rome ‚Äď was AMD bis¬≠her offi¬≠zi¬≠ell ver¬≠ra¬≠ten hat

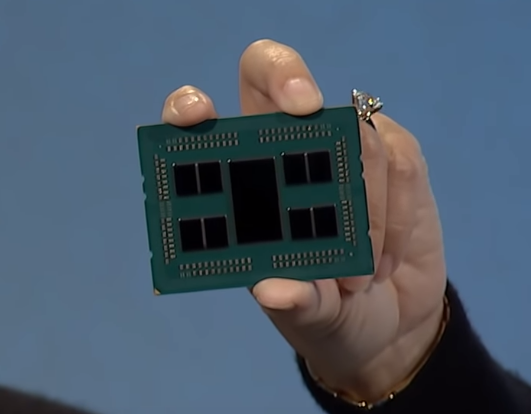

Auf der in San Fran¬≠cis¬≠co abge¬≠hal¬≠te¬≠nen ‚ÄúNext Hori¬≠zon‚ÄĚ Pr√§¬≠sen¬≠ta¬≠ti¬≠on hat AMD den Vor¬≠hang gel√ľf¬≠tet. Der Ser¬≠ver-Pro¬≠zes¬≠sor Epyc ‚ÄúRome‚ÄĚ im Spe¬≠zi¬≠el¬≠len wird wie schon der aktu¬≠el¬≠le Nap¬≠les ein Mul¬≠ti-Chip-Design wer¬≠den. Aller¬≠dings geht AMD bei Rome noch einen Schritt wei¬≠ter und rea¬≠li¬≠siert die CPU nicht mit iden¬≠ti¬≠schen Dies, son¬≠dern trennt Rechen¬≠ein¬≠hei¬≠ten und I/O. So wird Rome aus bis zu 8 Com¬≠pu¬≠te-Chip¬≠lets bestehen, die je 8 Ker¬≠ne auf¬≠wei¬≠sen, sowie aus einem I/O‚ÄĎChip.

W√§h¬≠rend die eigent¬≠li¬≠chen Rechen-Chip¬≠lets in 7 nm bei TSMC gefer¬≠tigt wer¬≠den, kommt der I/O‚ÄĎChip nach wie vor in 14 nm daher. Der Sinn dahin¬≠ter ist, dass vie¬≠le Kom¬≠po¬≠nen¬≠ten im I/O‚ÄĎBereich nicht so sehr von der Schrump¬≠fung der Fer¬≠ti¬≠gung pro¬≠fi¬≠tie¬≠ren und daher bes¬≠ser im g√ľns¬≠ti¬≠ge¬≠ren 14-nm-Ver¬≠fah¬≠ren pro¬≠du¬≠ziert wer¬≠den k√∂n¬≠nen. Zudem wird AMD sicher¬≠lich nach wie vor Abnah¬≠me¬≠ver¬≠tr√§¬≠ge mit sei¬≠ner ehe¬≠ma¬≠li¬≠gen haus¬≠ei¬≠ge¬≠nen Fab (jetzt Glo¬≠bal¬≠Found¬≠ries) haben, die auf die¬≠se Wei¬≠se erf√ľllt wer¬≠den k√∂n¬≠nen, obwohl die eigent¬≠li¬≠chen Zen-2-Dies bei TSMC in 7 nm pro¬≠du¬≠ziert wer¬≠den. Kom¬≠mu¬≠ni¬≠ziert wur¬≠de auch, dass AMD mit Rome PCI-Express 4.0 ein¬≠f√ľh¬≠ren wird (sofern das Main¬≠board es unter¬≠st√ľtzt), es bei acht Spei¬≠cher¬≠ka¬≠n√§¬≠len bleibt (DDR4 logi¬≠scher¬≠wei¬≠se, da DDR5 noch nicht ein¬≠ge¬≠f√ľhrt wur¬≠de) und die zwei¬≠te Gene¬≠ra¬≠ti¬≠on der soge¬≠nann¬≠ten Infi¬≠ni¬≠ty Fabric zum Ein¬≠satz kommt, also der Kom¬≠mu¬≠ni¬≠ka¬≠ti¬≠ons¬≠pfad zwi¬≠schen den ein¬≠zel¬≠nen Ker¬≠nen, die sich nicht im sel¬≠ben Seg¬≠ment befinden.

Auch zur Zen-2-Archi¬≠tek¬≠tur als sol¬≠cher wur¬≠den Details genannt, wie etwa die ver¬≠bes¬≠ser¬≠te Exe¬≠cu¬≠ti¬≠on Pipe¬≠line, die ver¬≠bes¬≠ser¬≠te Sprung¬≠vor¬≠her¬≠sa¬≠ge samt Pre¬≠fet¬≠ching, der opti¬≠mier¬≠te Befehls¬≠cache, ein gr√∂¬≠√üe¬≠rer Op-Cache und ‚Äď ganz wich¬≠tig ‚Äď die dop¬≠pelt so brei¬≠te FPU, die nun 256 Bit in einem Rutsch ver¬≠ar¬≠bei¬≠ten kann statt zwei Mal 128 Bit nach¬≠ein¬≠an¬≠der. Dazu wur¬≠de auch die Load-/Sto¬≠re-Band¬≠brei¬≠te ver¬≠dop¬≠pelt. Zudem hat AMD ver¬≠spro¬≠chen, dass Gegen¬≠ma√ü¬≠nah¬≠men zu den Sicher¬≠heits¬≠pro¬≠ble¬≠men der Spect¬≠re-Fami¬≠lie per Hard¬≠ware getrof¬≠fen wurden.

Die ers¬≠ten Main¬≠boards f√ľr Rome

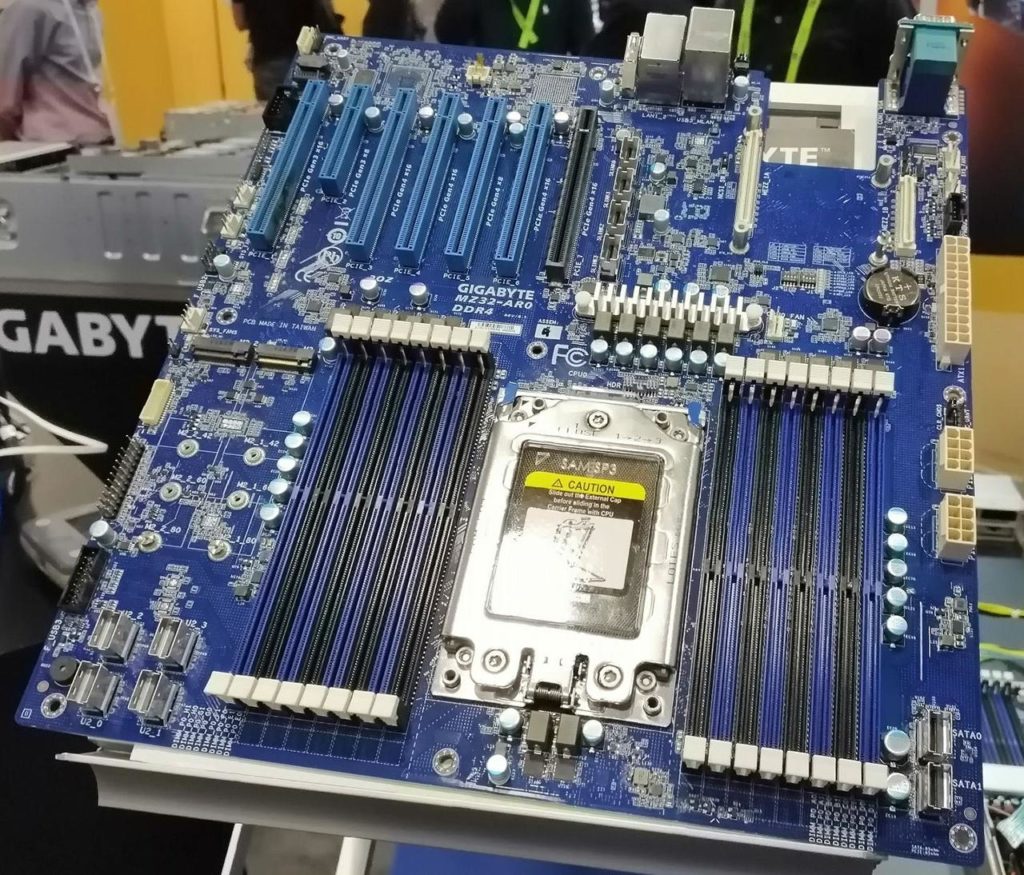

Inter¬≠es¬≠san¬≠ter¬≠wei¬≠se hat AMD auf der ‚ÄúNext Horizon‚ÄĚ-Pr√§sentation nicht expli¬≠zit den Sockel SP3 erw√§hnt. Zur Markt¬≠ein¬≠f√ľh¬≠rung des Nap¬≠les hat¬≠te AMD aller¬≠dings betont, dass der Sockel SP3 √ľber Jah¬≠re die desi¬≠gnier¬≠te Ser¬≠ver-Platt¬≠form blei¬≠ben wird. Damit d√ľrf¬≠ten auch CPU-Upgrades per Drop-In-Repla¬≠ce¬≠ment m√∂g¬≠lich sein, sofern Main¬≠board-Her¬≠stel¬≠ler ihre Nap¬≠les-Pla¬≠ti¬≠nen per BIOS-Update fit f√ľr Rome machen. In der Zwi¬≠schen¬≠zeit hat Giga¬≠byte ein Main¬≠board f√ľr Rome gezeigt, das neben der Beschrif¬≠tung ‚ÄúPCIe Gen 4‚ÄĚ auch expli¬≠zit ‚ÄúSP3‚ÄĚ als Sockel ein¬≠gra¬≠viert hat.

Der Die-Auf­bau und die Caches

Offi¬≠zi¬≠ell sagt AMD bis¬≠her nichts dazu, aber bereits vor √ľber einem Jahr ging das Ger√ľcht um, dass AMD bei Rome die Kern¬≠an¬≠zahl ver¬≠dop¬≠peln und die L3-Cache¬≠gr√∂¬≠√üe ver¬≠vier¬≠fa¬≠chen wird. Die Ver¬≠dop¬≠pe¬≠lung der Kern¬≠an¬≠zahl ist tat¬≠s√§ch¬≠lich so ein¬≠ge¬≠tre¬≠ten, sodass die Ger√ľch¬≠te zur vier¬≠fa¬≠chen Cache¬≠gr√∂¬≠√üe (bzw. Ver¬≠dop¬≠pe¬≠lung je Kern) nicht aus¬≠zu¬≠schlie¬≠√üen sind.

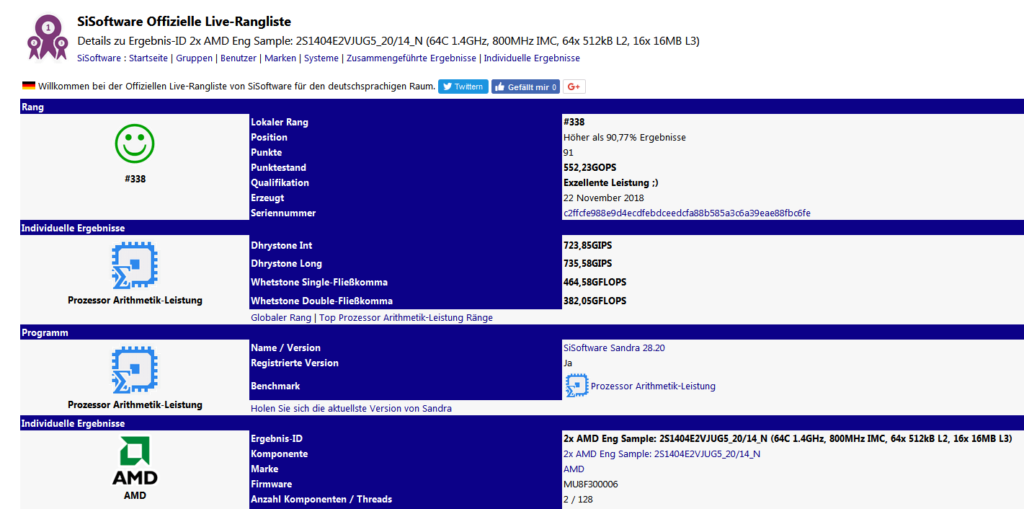

Ver­gan­ge­ne Woche ist ein Ein­trag in der SiS­oft­ware-Daten­bank auf­ge­taucht (inzwi­schen wie­der ver­schwun­den), der von einem Rome Engi­nee­ring-Sam­ple stam­men soll.

Das Engi¬≠nee¬≠ring-Sam¬≠ple mit der Bezeich¬≠nung 2S1404E2VJUG5_20/14_N soll 64 Ker¬≠ne auf¬≠wei¬≠sen, die mit 1,4 GHz getak¬≠tet sind. Das w√§re selbst f√ľr ein Engi¬≠nee¬≠ring-Sam¬≠ple recht wenig. Aller¬≠dings kann nat√ľr¬≠lich sein, dass AMD ange¬≠sichts der √ľber¬≠bor¬≠den¬≠den Anzahl an Ker¬≠nen den Basistakt betont nied¬≠rig ansetzt um inner¬≠halb der f√ľr SP3 √ľbli¬≠chen TDP zu blei¬≠ben, und dann bei den fina¬≠len Samples den Rest per Tur¬≠bo erle¬≠digt. Das ist auch bei unse¬≠rem Nap¬≠les im Pla¬≠net 3DNow! Web¬≠ser¬≠ver so. Der hat einen Basistakt von nur 2,4 GHz, l√§uft aber prak¬≠tisch durch¬≠ge¬≠hend im Tur¬≠bo¬≠mo¬≠dus um 2,8 GHz her¬≠um, selbst dann, wenn man k√ľnst¬≠lich alle Ker¬≠ne belastet.

Inter¬≠es¬≠san¬≠ter als der Takt, der sich nat√ľr¬≠lich noch √§ndern kann und wird bei den fina¬≠len Pro¬≠duk¬≠ten, ist die Anga¬≠be zum Cache: 16x 16 MB L3-Cache steht dort. Zum einen w√§ren das 256 MB und damit wirk¬≠lich vier¬≠mal so viel wie bei Nap¬≠les, wo maxi¬≠mal 64 MB L3-Cache bereit¬≠ste¬≠hen. Zum ande¬≠ren sagt auch die Anga¬≠be ‚Äú16x‚ÄĚ eini¬≠ges √ľber den Chip¬≠auf¬≠bau aus, sofern San¬≠dra die Archi¬≠tek¬≠tur kor¬≠rekt aus¬≠ge¬≠le¬≠sen hat. Da AMD bereits kom¬≠mu¬≠ni¬≠ziert hat, dass Rome aus acht Zen-2-Dies bestehen wird, w√ľr¬≠de der Umstand, dass der L3-Cache aus 16 Seg¬≠men¬≠ten besteht, dar¬≠auf hin¬≠deu¬≠ten, dass jedes Zen-2-Die ‚Äď so wie bei Zen 1 ‚Äď aus zwei CCX bestehen wird. Also kein homo¬≠ge¬≠nes 8‚ÄĎKern-Die mit glei¬≠chen Zugriffs¬≠zei¬≠ten f√ľr alle Ker¬≠ne, son¬≠dern wei¬≠ter¬≠hin zwei CCX mit je 4 Ker¬≠nen, die via Infi¬≠ni¬≠ty Fabric zusam¬≠men¬≠ge¬≠schal¬≠tet sind. Nur, dass jeder CCX dann 16 MB L3-Cache haben wird statt nur 8 MB wie bei Zen 1.

Was steckt im I/O‚ÄĎDie?

Wie erw√§hnt hat AMD die f√ľr I/O zust√§n¬≠di¬≠gen Kom¬≠po¬≠nen¬≠ten bei Rome in einen eige¬≠nen Chip aus¬≠ge¬≠la¬≠gert. I/O wird bedeu¬≠ten: Memo¬≠ry-Con¬≠trol¬≠ler, PCI-Express Con¬≠trol¬≠ler, aber bei einem SoC wie Epyc auch SATA-Con¬≠trol¬≠ler, USB-Con¬≠trol¬≠ler, even¬≠tu¬≠ell auch Netz¬≠werk-MACs oder gan¬≠ze Netz¬≠werk-Con¬≠trol¬≠ler. Das wur¬≠de aber noch nicht verraten.

Und trotz¬≠dem. Sieht man sich das Die auf den gezeig¬≠ten Fotos an, dann ist der Chip nur daf√ľr zu gro√ü; erheb¬≠lich zu gro√ü. Der Gro√ü¬≠teil eines her¬≠k√∂mm¬≠li¬≠chen Dies wird ohne¬≠hin vom Cache belegt. Das sind die auf Dieshots gleich¬≠for¬≠mig erschei¬≠nen¬≠den Berei¬≠che, in denen die SRAM-Zel¬≠len f√ľr die Caches lie¬≠gen. Unter¬≠stellt man, dass auch bei Zen 2 die L3-Caches m√∂g¬≠lichst nahe bei den Ker¬≠nen (also in den Chip¬≠lets) plat¬≠ziert wer¬≠den, wes¬≠halb ist dann der I/O‚ÄĎChip so rie¬≠sig? Dazu schweigt sich AMD lei¬≠der noch v√∂l¬≠lig aus.

Denk¬≠bar w√§re, dass AMD zus√§tz¬≠lich zu den L3-Caches, den jedes der 8 Chip¬≠lets besitzt, noch eine wei¬≠te¬≠re Cache¬≠stu¬≠fe vor¬≠ge¬≠se¬≠hen hat, dem¬≠nach einen L4-Cache, der dann im I/O‚ÄĎChip ste¬≠cken k√∂nn¬≠te. Qua¬≠si wie fr√ľ¬≠her bei den Sockel-7-Board, wo zus√§tz¬≠lich zu den On-Die-Caches noch ein Cache auf dem Main¬≠board plat¬≠ziert war; hier dann eben nicht auf dem Main¬≠board, son¬≠dern auf dem Chip¬≠tr√§¬≠ger. Doch ist das wahr¬≠schein¬≠lich? Bei einem Pro¬≠zes¬≠sor, des¬≠sen L3-Cache ohne¬≠hin schon ver¬≠vier¬≠facht wur¬≠de? Zudem hat San¬≠dra kei¬≠nen L4-Cache aus¬≠ge¬≠le¬≠sen (was aber nichts hei¬≠√üen muss, da San¬≠dra sicher¬≠lich noch kei¬≠ne Rome-Unter¬≠st√ľt¬≠zung hatte).

Eben¬≠falls denk¬≠bar w√§re, dass der L3-Cache nicht mehr in den Chip¬≠lets steckt, son¬≠dern im I/O‚ÄĎChip plat¬≠ziert wur¬≠de. Dann w√ľr¬≠de des¬≠sen Gr√∂¬≠√üe ange¬≠sichts von 256 MB L3-Cache pas¬≠sen und AMD kann sie ja in Sli¬≠ces a 16 MB orga¬≠ni¬≠siert haben. Aber m√ľss¬≠ten dann nicht die Chip¬≠lets wesent¬≠lich klei¬≠ner sein, wenn sich dort kein gro¬≠√üer L3-Cache mehr befin¬≠det? Eigent¬≠lich schon. Aller¬≠dings muss bedacht wer¬≠den, dass AMD die FPU von 128 auf 256 Bit auf¬≠ge¬≠bohrt hat. Man erin¬≠ne¬≠re sich an die Umstel¬≠lung von K8 auf K10, als AMD von einer 64 auf eine 128 Bit FPU ging, wie sehr das den Bereich der Ker¬≠ne auf¬≠ge¬≠bl√§ht hat obwohl (oder weil) die Fer¬≠ti¬≠gung mit 65 nm gleich geblie¬≠ben war. Die neue 256-Bit-FPU bei Zen 2 gibt es sicher¬≠lich nicht umsonst. Ob die¬≠se allein aller¬≠dings erkl√§¬≠ren kann, dass die Chip¬≠lets so gro√ü sind wie sie sind?

√úber all das kann nat√ľr¬≠lich in unse¬≠rem Spe¬≠ku¬≠la¬≠ti¬≠ons¬≠be¬≠reich im Forum dis¬≠ku¬≠tiert und debat¬≠tiert werden.

Links zum Thema:

- Web­watch und AMD-News zum Wochen­en­de (KW 47) ()

- Web­watch und AMD-News zum Wochen­en­de (KW 46) ()

- Giga¬≠byte zeigt ers¬≠tes Ser¬≠ver-Main¬≠board f√ľr Rome mit PCI-Express 4.0 ()

- AMDs Zen 2 Rome kommt mit 64 Ker­nen im Chip­let-Design ()

- AMD Zen 2 angeb­lich mit 13 Pro­zent IPC-Stei­ge­rung ()

- Glo¬≠ba¬≠le Ser¬≠ver¬≠aus¬≠lie¬≠fe¬≠run¬≠gen stei¬≠gen 2018 stark ‚ÄĒ eine Chan¬≠ce f√ľr AMD ()

- Offi­zi­ell: AMDs Zen 2 wird bei TSMC in 7 nm gefer­tigt ()