AMD A10-7700K und A10-7850K im Test

cTDP und seine Auswirkungen

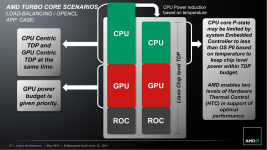

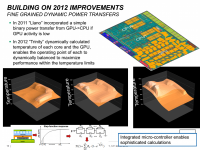

AMD sorg┬Łte vor eini┬Łgen Jah┬Łren mit der Ein┬Łf├╝h┬Łrung der ACP (Avera┬Łge CPU Power) f├╝r Ser┬Łver-CPUs als Ma├¤ f├╝r die mitt┬Łle┬Łre Ver┬Łlust┬Łleis┬Łtung f├╝r Auf┬Łse┬Łhen und muss┬Łte Kri┬Łtik ein┬Łste┬Łcken. Auch Intel ist inzwi┬Łschen von der Anga┬Łbe einer ŌĆ£rea┬Łlis┬Łti┬ŁschenŌĆØ Ver┬Łlust┬Łleis┬Łtung abge┬Łr├╝ckt. Die Sinn┬Łhaf┬Łtig┬Łkeit einer sol┬Łchen mitt┬Łle┬Łren Ver┬Łlust┬Łleis┬Łtung ist unse┬Łrer Ansicht nach aber unbe┬Łstreit┬Łbar. Nur weni┬Łge Anwen┬Łdun┬Łgen sor┬Łgen daf├╝r, dass die defi┬Łnier┬Łte TDP aus┬Łge┬Łreizt oder ├╝ber┬Łschrit┬Łten wird. Bereits bei den Tests von Mini-ITX-Geh├żu┬Łsen m├╝s┬Łsen wir stets von der Nut┬Łzung soge┬Łnann┬Łter Kil┬Łler-Anwen┬Łdun┬Łgen (z.B. Fur┬ŁMark und Prime95) Abstand neh┬Łmen. Auch wenn die TDP unse┬Łrer A10-5700-APU mit 65 Watt ange┬Łge┬Łben wird, so zeigt uns das Ener┬Łgie┬Łkos┬Łten┬Łmess┬Łge┬Łr├żt eine ande┬Łre Rea┬Łli┬Łt├żt. Dabei hat sich AMD schon mit der Ein┬Łf├╝h┬Łrung der Llano-APUs (2011) mit dem The┬Łma besch├żf┬Łtigt, wie die Ver┬Łlust┬Łleis┬Łtung inner┬Łhalb der defi┬Łnier┬Łten Gren┬Łzen gehal┬Łten wer┬Łden kann.

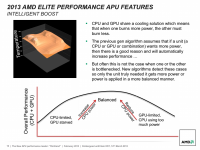

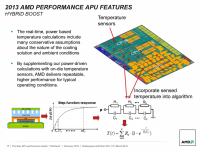

├£ber die APU-Gene┬Łra┬Łtio┬Łnen hin┬Łweg hat AMD das Power-Manage┬Łment ver┬Łfei┬Łnert. Mit┬Łhil┬Łfe von inte┬Łgrier┬Łten ther┬Łmi┬Łschen Wider┬Łst├żn┬Łden wird eine Tem┬Łpe┬Łra┬Łtur┬Łdif┬Łfe┬Łrenz zur maxi┬Łmal erlaub┬Łten Betriebs┬Łtem┬Łpe┬Łra┬Łtur bestimmt. Zus├żtz┬Łlich wer┬Łden Berech┬Łnungs┬Łal┬Łgo┬Łrith┬Łmen genutzt, um die unge┬Łf├żh┬Łre Leis┬Łtungs┬Łauf┬Łnah┬Łme in das Regel┬Łver┬Łhal┬Łten miteinzubeziehen.

F├╝r Note┬Łbook-OEMs ist seit der Ein┬Łf├╝h┬Łrung der Rich┬Łland-APUs cTDP ein nutz┬Łba┬Łres Fea┬Łture. Die con┬Łfi┬Łgura┬Łble TDP erm├Čg┬Łlicht es, die maxi┬Łma┬Łle ther┬Łmi┬Łsche Ver┬Łlust┬Łleis┬Łtung per Soft┬Łware zu begren┬Łzen. Bis auf die A10-7700K-APU unter┬Łst├╝tz┬Łten nach AMD-Anga┬Łben alle Kaveri-APUs cTDP. Wie das Fea┬Łture umge┬Łsetzt wird, obliegt aber dem Main┬Łboard┬Łher┬Łstel┬Łler. Giga┬Łbyte bei┬Łspiels┬Łwei┬Łse lie┬Łfer┬Łte erst mit mona┬Łte┬Łlan┬Łger Ver┬Łsp├ż┬Łtung das Fea┬Łture f├╝r das von uns genutz┬Łte GA-F2A88XM-D3H mit┬Łhil┬Łfe eines BIOS-/UE┬ŁFI-Updates nach. Unter Umst├żn┬Łden kann auch nur eine Stu┬Łfe ange┬Łw├żhlt wer┬Łden, n├żm┬Łlich 45 Watt.

Wie sieht das Ver┬Łhal┬Łten des Sys┬Łtems nun aber unter Nut┬Łzung von cTDP aus?

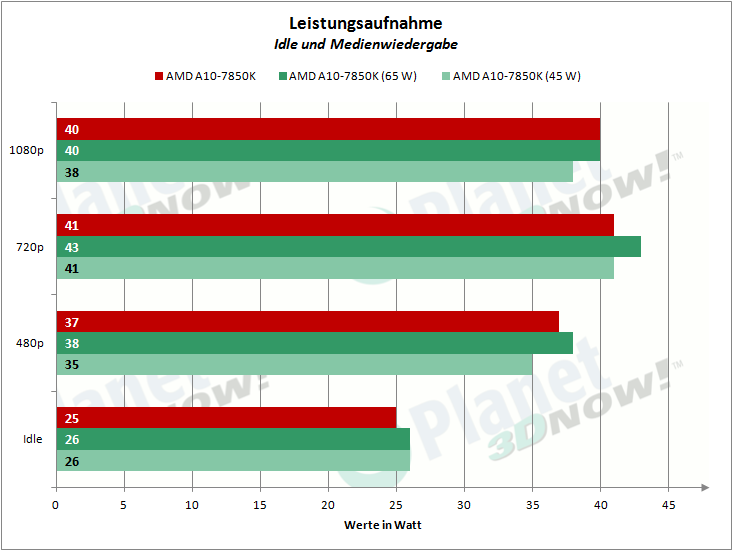

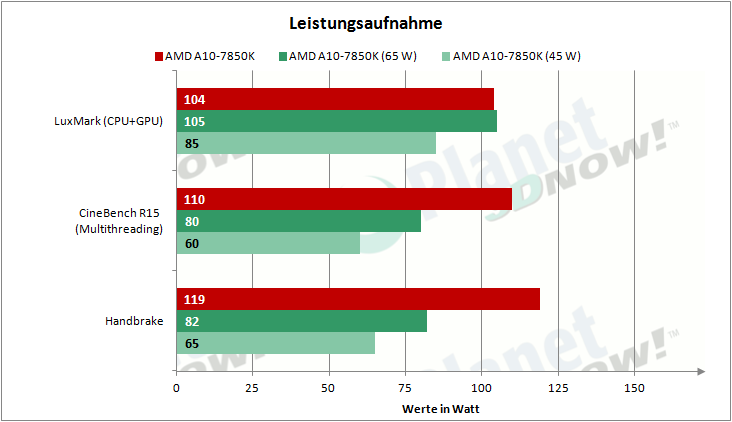

Unse┬Łren Beob┬Łach┬Łtun┬Łgen zufol┬Łge wer┬Łden die APU-Tem┬Łpe┬Łra┬Łtur und die Leis┬Łtungs┬Łauf┬Łnah┬Łme tat┬Łs├żch┬Łlich aktiv in das Regel┬Łver┬Łhal┬Łten mit┬Łein┬Łbe┬Łzo┬Łgen. Da die Mes┬Łsung der GPU-Takt┬Łra┬Łte nahe┬Łzu unm├Čg┬Łlich ist, bleibt uns nur die Anga┬Łbe der CPU-Takt┬Łra┬Łte, die ma├¤┬Łgeb┬Łlich beein┬Łflusst wird. Beim Mul┬Łti┬Łth┬Łread-CPU-Bench┬Łmark (Cine┬ŁBench R15) redu┬Łziert sich die maxi┬Łma┬Łle Takt┬Łfre┬Łquenz von 3900 MHz auf 3500 MHz, beim Spie┬Łlen von Tomb Rai┬Łder (2013) wie┬Łder┬Łum sehen wir nur sel┬Łte┬Łne Drops von 3000 MHz auf 2400 MHz. Letz┬Łte┬Łre Takt┬Łra┬Łte wird ange┬Łsetzt, wenn cTDP auf 45 Watt ein┬Łge┬Łstellt wird.

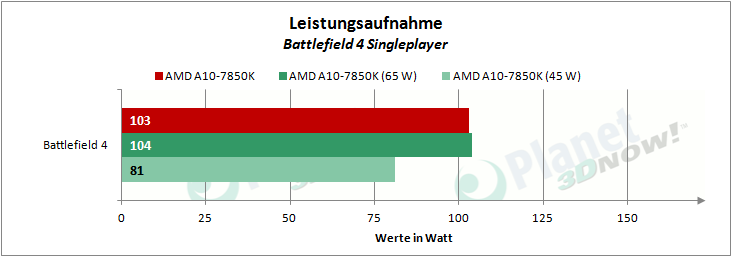

Der Tem┬Łpe┬Łra┬Łtur┬Łein┬Łfluss macht sich bei der Leis┬Łtungs┬Łauf┬Łnah┬Łme bemerk┬Łbar. Bei kurz┬Łzei┬Łti┬Łger CPU-Last sehen wir Takt┬Łspit┬Łzen, erst im wei┬Łte┬Łren Ver┬Łlauf wird her┬Łun┬Łter┬Łge┬Łre┬Łgelt. Das bedeu┬Łtet, dass wir auf dem Ener┬Łgie┬Łkos┬Łten┬Łmess┬Łge┬Łr├żt Spit┬Łzen von 106 Watt (65 W cTDP) und 96 Watt (45 W cTDP) bei Tomb Rai┬Łder (2013) beob┬Łach┬Łten k├Čn┬Łnen. Der Durch┬Łschnitts┬Łver┬Łbrauch betr├żgt 104 Watt (65 W cTDP) bzw. 81 Watt (45 Watt cTDP).

Die┬Łses Ver┬Łhal┬Łten zeigt uns, dass trotz cTDP wei┬Łter┬Łhin ein aus┬Łrei┬Łchend star┬Łkes Netz┬Łteil vor┬Łhan┬Łden sein muss, um das Sys┬Łtem auch bei die┬Łsen Spit┬Łzen mit aus┬Łrei┬Łchend Strom zu ver┬Łsor┬Łgen. F├╝r HTPC-Nut┬Łzer k├Čnn┬Łte es also sinn┬Łvoll sein, von vorn┬Łher┬Łein 65-W-APUs zu kau┬Łfen und die┬Łse dann her┬Łun┬Łter┬Łzu┬Łre┬Łgeln, falls kein aus┬Łrei┬Łchend star┬Łkes Netz┬Łteil zur Ver┬Łf├╝┬Łgung steht.

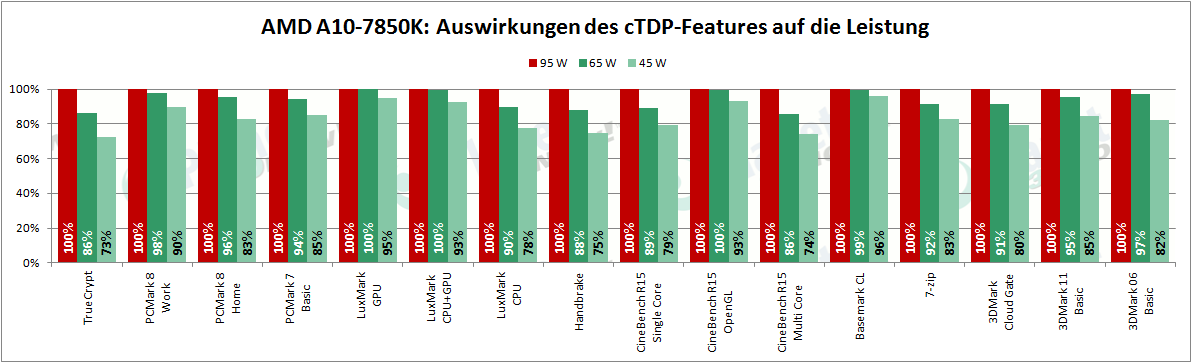

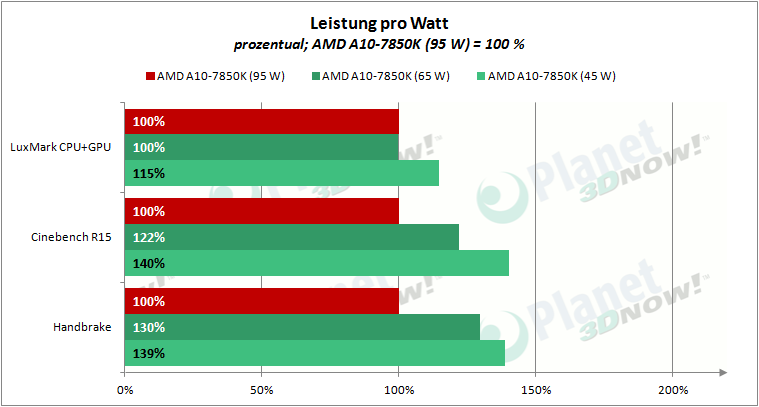

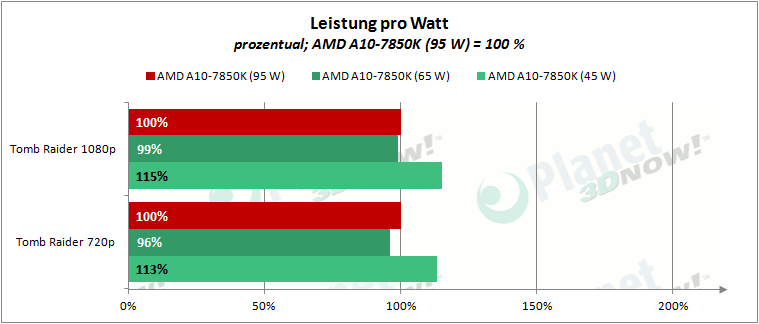

Die Rechen┬Łleis┬Łtung des Sys┬Łtems wird selbst┬Łver┬Łst├żnd┬Łlich unter┬Łschied┬Łlich stark durch die gew├żhl┬Łte cTDP beeinflusst.

W├żh┬Łrend die Begren┬Łzung der TDP auf 65 Watt (- 32 %) die Leis┬Łtung um bis zu 14 % sin┬Łken l├żsst, sind es bei 45 Watt (- 53 %) bis zu 27 %.

Abso┬Łlut┬Łwer┬Łte f├╝r: Batt┬Łle┬Łfield 4, Bio┬Łs┬Łhock Infi┬Łni┬Łte, Crysis 3, Hit┬Łman Abso┬Łlu┬Łti┬Łon, Tomb Rai┬Łder

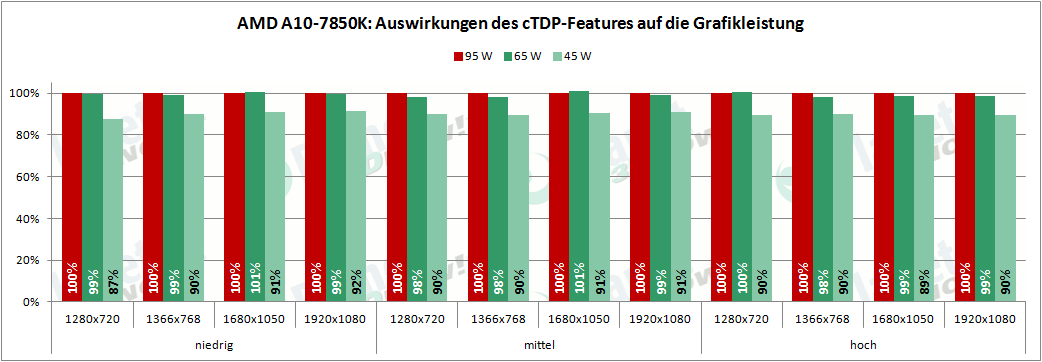

Spe┬Łzi┬Łell bei Spie┬Łlen sehen wir ein ande┬Łres Bild. Bei 65 Watt sehen wir auf den ers┬Łten Blick kei┬Łnen nen┬Łnens┬Łwer┬Łten Ein┬Łbruch bei den durch┬Łschnitt┬Łli┬Łchen Bild┬Łra┬Łten. Die Beschr├żn┬Łkung auf 45 Watt TDP hin┬Łge┬Łgen bedeu┬Łtet 13 % nied┬Łri┬Łge┬Łre Bild┬Łra┬Łten. Die┬Łse 13 % machen mit┬Łun┬Łter auch den gro┬Łben Unter┬Łschied zwi┬Łschen spiel┬Łbar und nicht spiel┬Łbar aus.

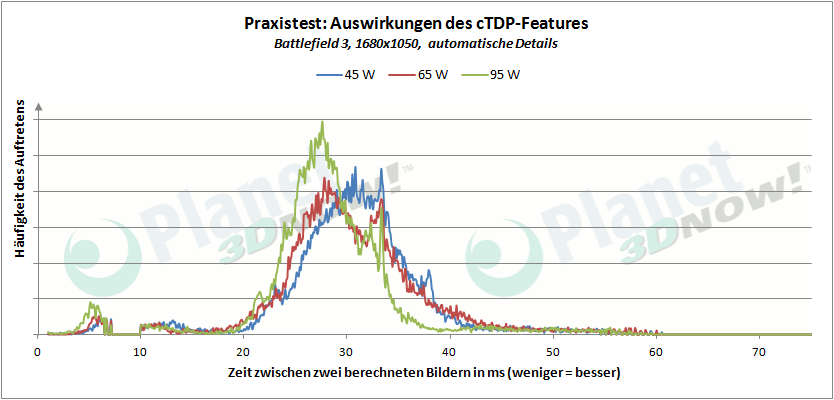

Wir spie┬Łlen zus├żtz┬Łlich die ers┬Łte hal┬Łbe Stun┬Łde des Ego-Shoo┬Łters Batt┬Łle┬Łfield 3. Anhand der Aus┬Łwer┬Łtung der Frame┬Łti┬Łmes, der vom Tool FRAPS auf┬Łge┬Łzeich┬Łne┬Łten Abst├żn┬Łde zwi┬Łschen zwei ger┬Łen┬Łder┬Łten Bil┬Łdern, zei┬Łgen sich deut┬Łli┬Łche Unter┬Łschie┬Łde zu den vor┬Łhe┬Łri┬Łgen Benchmarks.

Die Spit┬Łzen inner┬Łhalb der Kur┬Łven repr├ż┬Łsen┬Łtie┬Łren Ingame-Video┬Łse┬Łquen┬Łzen und Lade┬Łse┬Łquen┬Łzen. Trotz┬Łdem sehen wir, dass die Kur┬Łve im 65-W-Betrieb deut┬Łlich fla┬Łcher aus┬Łf├żllt. Die Frame┬Łti┬Łmes und damit die Bild┬Łra┬Łte (=1000 ms/Frametime) streu┬Łen st├żr┬Łker. Gleich┬Łzei┬Łtig sehen wir, dass die Bild┬Łra┬Łte in die┬Łsem spe┬Łzi┬Łel┬Łlen Fall gerin┬Łger aus┬Łf├żllt. Die Fest┬Łle┬Łgung von cTDP auf 45 Watt sorgt f├╝r die wei┬Łte┬Łre, voll┬Łkom┬Łmen erwar┬Łte┬Łte Redu┬Łzie┬Łrung der Bild┬Łra┬Łte (Erh├Č┬Łhung der Frame┬Łti┬Łmes). Hier macht sich offen┬Łbar das von uns f├╝r die 65 W cTDP beob┬Łach┬Łte┬Łte Sprin┬Łgen der CPU-Takt┬Łra┬Łten zwi┬Łschen 2,4 GHz und 3,0 GHz bemerkbar.

Sowohl die Rechen┬Łleis┬Łtung als auch die Leis┬Łtungs┬Łauf┬Łnah┬Łme sinkt, das haben wir gese┬Łhen. Hin┬Łsicht┬Łlich der Effi┬Łzi┬Łenz (z.B. FPS/Watt) sehen wir, dass die┬Łse nicht in allen Sze┬Łna┬Łri┬Łen steigt. Bei rei┬Łner CPU-Last sehen wir eine um bis zu 40 % h├Čhe┬Łre Effi┬Łzi┬Łenz, w├żh┬Łrend GPU-las┬Łti┬Łge Anwen┬Łdun┬Łgen ŌĆ£nurŌĆØ f├╝r 15 % bes┬Łse┬Łre Wer┬Łte gut sind.